Par Jean-Michel Salaun le mardi 11 septembre 2007, 02:14 - Édition

L'avenir de la presse continue de susciter bien des inquiétudes des deux côtés de l'Atlantique. Ce n'est pas nouveau et P. Lozeau les avait synthétisées ce printemps pour ce blogue dans un billet. Nous savons aussi qu'il faut nuancer sérieusement l'analyse (voir ici), si l'on raisonne à l'échelle de la planète. Mais le mouvement s'accélère et les observateurs multiplient les analyses.

Parmi les nombreuses alertes récentes, il faut de nouveau saluer du côté francophone la veille, fine intelligente et constante, d'E. Parody, partiale mais toujours documentée et analytique. Depuis la rentrée, trois billets au moins rencontrent directement les préoccupations de ce blogue :

- Le risque induit par le préférence de Google-news pour les dépêches d'agence (ici)

- La chute des effectifs des journaux (ici)

- La difficile adaptation du modèle économique de la presse aux flux RSS (ici)

Sans revenir en détail sur ces points, je voudrais les mettre dans la perspective d'une analyse en modèles (voir ici pour la présentation des modèles) à partir de deux constats, tirés de deux publications récentes : le nouveau modèle du Web-média s'installe sans ménagement pour les anciens ; l'ancien modèle de la presse a une forte inertie.

L'insoutenable légèreté du Web-média

Un rapport récent de chercheurs de Harvard, au titre évocateur inspiré de Schumpeter (voir explication sur Wikipédia), fournit quelques indications sur l'évolution de l'audience des sites d'information :

Thomas E. Patterson, John F. Kennedy, Creative Destruction: An Exploratory Look at News on the Internet, Report from the Joan Shorenstein Center on the Press, Politics and Public Policy, Août 2007 Pdf

L'audience de 160 sites d'information a été suivie pendant un an. Extrait du résumé (trad JMS) :

Les sites des journaux nationaux au titre reconnu sont en croissance, tandis que ceux de beaucoup de journaux locaux ne le sont pas. Les sites des réseaux de télévision reconnus voient aussi croître leur traffic, tout comme ceux des stations locales de télévision et de radio. Cependant, les sites dépendant des organisations traditionnelles de nouvelles croissent moins vite que ceux des principaux diffuseurs de nouvelles non-traditionnels, comprenant les agrégateurs, les blogueurs, les moteurs de recherche et les offreurs de service.

Ainsi selon que l'on retienne les deux premières phrases ou la dernière, le verre serait à moité plein ou à moitié vide et on pourrait conclure à un relatif optimisme pour les médias traditionnels les plus reconnus à condition de rester vigilant. Cette conclusion est malheureusement erronée. La croissance de l'audience des médias traditionnels ne signifie pas une croissance parallèle de leurs rentrées publicitaires. La publicité a tendance à creuser les écarts, allant naturellement vers le média le plus porteur, c'est à dire vers celui auquel est attaché l'image la plus positive.

Mais il y a bien plus : les deux modèles sont antagoniques et, au moins jusqu'à qu'il soit stabilisé, le succès sur le marché de l'attention du plus jeune se fait au détriment de l'autre. Je n'y reviens pas, je l'ai déjà largement expliqué (ici) et les remarques d'E. Parody le soulignent assez, en montrant toute la difficulté à rendre compatible les deux modèles.

Pire encore : L'antagonisme ne se manifeste pas seulement sur les parts du marché publicitaire, mais aussi sur la structure du média lui-même. Je ne prendrai que l'exemple de Google-news. On oublie souvent que ce service ne rapporte rien directement à son promoteur. Il n'y pas, pour le moment, de publicité sur ce service. Là encore, l'analyse par modèles est éclairante.

Pour Google-news, la firme mère s'est inspirée du modèle de la bibliothéconomie pour la structure médiatique du service et pour sa régulation : une revue (ou «panorama» selon le terme consacré en documentation) de presse ; le fair-use même si celui-ci a rencontré quelques oppositions selon la position des acteurs et la législation particulière des pays. Cette inspiration était intéressante : en effet, il n'y a pas de concurrence commerciale de ce côté, puisque le modèle bibliothéconomique n'est pas financé par le marché. Cette position d'homologie n'est donc tenable pour Google-news qu'à condition de ne pas rentrer sur le marché publicitaire.

Par ailleurs, la firme rompt avec ce modèle primitif grâce à la performance de ses outils automatiques. La structure de coûts du service n'a rien à voir avec celle, très lourde, de la bibliothéconomie. Mieux encore Google-news paraît concrétiser un vieux rêve de complémentarité entre le modèle bibliothéconomique et celui de la presse, puisqu'il oriente l'audience vers les encarts publicitaires des sites d'information cette dernière. Ainsi, Google-news s'est assuré, malgré quelques réticences, une relative neutralité du côté de la presse.

On peut alors se poser la question de l'intérêt pour Google de monter un service qui lui coute de l'argent et favorise les rentrées financières de ses concurrents sur le marché publicitaire. Pour y répondre, il faut considérer que le modèle du Web-média n'est pas encore stabilisé et prendre très au sérieux la mention Béta qui est faite sur la page du service.

À court terme, il s'agit d'occuper le terrain afin de monter les barrières à l'entrée pour d'autres acteurs intéressés sur les services de recherche d'informations. Tout ce qui fragilise les concurrents rapporte indirectement à Google, puisqu'il est, par ailleurs et de très loin, leader du marché publicitaire sur le Web. À moyen terme néanmoins, Google-news pourrait être prisonnier de sa réussite et devra rémunérer certains contenus, ceux qui viennent de professionnels, sinon il tarira ses sources les plus fiables. On en voit les prémisses dans les négociations avec les agences de presse. Ceci impliquera aussi une rentabilisation directe du service et donc vraisemblablement l'entrée de la publicité dans le service. Mais en attendant, plus il fragilise les producteurs aujourd'hui, meilleure demain sera sa position pour négocier.

En réalité, la limite de l'exercice pourrait être le succès de la firme Google elle-même. Elle ne peut-être un modèle de média à un seul acteur. Et il est à prévoir que les réactions se feront de plus en plus vive, dénonçant le monopole, à l'instar de celles particulièrement virulentes d'O. Ertzscheid (voir, parmi d'autres, celle-là).

Le poids du Quotidien

Cette stratégie est d'autant plus payante que le modèle de la presse a une forte inertie, tout particulièrement pour la presse quotidienne. J.-M. Charon, qui reste son meilleur analyste francophone, le montre clairement dans un article récent :

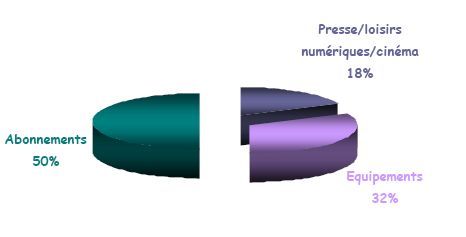

Charon Jean-Marie, L'économie de l'information, Structures et stratégies des groupes de presse, p.73-78. in Information, médias et internet, Cahiers Français n°338, mai - juin 2007, La Documentation française, sommaire *

Je cite :

En presse écrite le rythme quotidien constitue une différence de nature, imposant à un journal de collecter, traiter, mettre en forme, le plus souvent imprimer, voire distribuer lui-même l'information. C'est dire que la presse quotidienne se caractérise par des entreprises plus lourdes, regroupant de nombreux employés et cadres, notamment commerciaux, ainsi que des ouvriers et techniciens de fabrication.

Une telle structure est sans doute un gage d'indépendance, éditoriale et économique, en période de vaches grasses, mais c'est une source de rigidités quand vient la disette. Et, pour la presse quotidienne dans le monde occidental, il semble que nous soyons entrés dans ce cycle. On peut donc y prévoir encore de forts mouvements de concentration et de rationalisation. Dès lors, la voie est dégagée pour les nouveaux entrants du Web-média.

J'ajoute pour conclure que le raisonnement en modèles est éclairant pour décrypter les relations difficiles entre la presse et le Web-média, mais il l'est tout autant pour les autres modèles de médias (bibliothèque, édition, radio-télévision), bien entendu en le déclinant selon les spécificités de chacun.

-* Curieux numéro d'une revue, justement réputée, sur les relations de la presse et de l'internet où le mot Google n'est, sauf lecture trop rapide de ma part, jamais écrit, où aucune Url n'est citée dans les références. Bref, une résurgence de l'ancien monde dont je ne sauverais personnellement que l'article en question. Sévère peut-être, mais l'enjeu, comme voudrais le montrer ce billet, est lourd.