Par Jean-Michel Salaun le dimanche 09 août 2009, 23:34 - Moteurs

On a déjà beaucoup glosé sur Google comme moteur de recherche ou encore sur l'«écosystème» de Google, c'est à dire l'ensemble des services documentaires interconnectés qu'il propose afin de développer l'activité sur le Web, si possible à partir de ses sites. On sait aussi la firme très rentable et ses revenus provenant à 97% de la publicité. Mais on s'interroge peu sur la réussite de Google sur le marché publicitaire. Comment se fait-il qu'il séduise autant les annonceurs ?

La réussite de la firme tient en effet à une double innovation : Celle de son métier de base, la recherche d'information et tous ses à-côtés très suivis par les observateurs du Web ; mais aussi une rupture gagnante et plus méconnue avec les règles traditionnelles du marché publicitaire des médias qui lui a permis de rentabiliser de façon spectaculaire son cœur de métier selon les principes du marché bi-face (Wkp). Il manque aux services qui tiennent la vedette aujourd'hui sur le Web, Facebook ou Twitter, cette seconde dimension innovante. C'est pourquoi on peut douter de la pérennité de leur modèle actuel.

On le sait, la publicité chez Google repose sur l'achat de mots-clés, AdWords, qui détermine l'emplacement de l'affichage de l'annonce sur la page de requête de l'internaute ou sur celle des sites de son réseau correspondants à ces mots clés et sur le paiement par clic (PPC), contrairement au paiement par page-vue traditionnel de la publicité. Déjà ces procédures utilisent astucieusement le savoir-faire d'indexation de la firme. Elles sont généralement mises en avant pour expliquer l'insolente réussite de Google dans le domaine mais elles ne représentent pas la seule originalité, ni même peut-être la principale. Je crois que deux autres innovations se sont avérées décisives : l'utilisation encadrée des enchères et la prise en compte de la servuction dans la production d'une annonce. Cet ensemble présente une rupture radicale avec le marché publicitaire traditionnel.

Je ne parlerai pas ici de l'autre volet de l'activité publicitaire de Google, celui de régie : AdSense, sinon pour dire qu'il constitue aussi dans le chiffre d'affaires une part importante mais minoritaire et qui diminue régulièrement (ici) et que son objectif est aussi de soutenir l'affermage des sites extérieurs et leur permettant de trouver facilement un revenu.

Le jeu optimum des enchères

Il faut être prudent dans l'analyse car toutes les informations proviennent de la firme, une firme qui connait la valeur de l'information et en contrôle étroitement la circulation. Mais un article du numéro de juin de la revue de Wired éclaire crument le premier volet :

Steven Levy, “Secret of Googlenomics: Data-Fueled Recipe Brews Profitability,” Wired Magazine, juin 17, 2009, 108-115 ici

Selon le journaliste, c'est à partir d'une réflexion de Hal Varian, alors professeur d'économie à l'Université de Californie et aujourd'hui recruté par Google comme chief economist, que la firme s'est rendue compte, en 2002 alors qu'elle ne comptait que 200 employés, que son modèle d'affaires était basé principalement sur les enchères. À partir de ce moment là, la firme a fait le pari risqué de basculer la totalité de son système de vente des mots-clés sous le système qui n'était alors qu'expérimental des enchères. Varian, en effet, avait remarqué que le système répondait parfaitement aux questions posées par la théorie des jeux où un acteur ne prend de décision qu'en fonction de l'anticipation qu'il fait des décisions de ses concurrents (Wkp).

Une difficulté des enchères est que les clients ont peur de surenchérir trop fort et donc de payer un prix très au-delà de ce qu'ils auraient pu obtenir. L'idée simple d'abord développée chez Google est que chacun ne paiera que le prix de l'enchère de celui qui le suit plus un centime. L'enchérisseur n'a donc plus à craindre de jouer trop au-delà de ses concurrents. Le paradoxe est que cette procédure encourage l'augmentation des enchères.

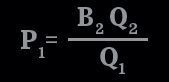

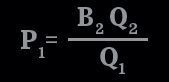

Mais le système d'enchères de Google est en réalité plus complexe. L'enchère n'est pas le seul paramètre pour déterminer le gagnant, Google y ajoute un indicateur de qualité de l'annonce. Et le prix payé est calculé selon cette formule :

P1 : Prix payé par l'annonceur - B2 : Enchère la plus haute la plus rapprochée - Q2 :Qualité de l'annonce de l'enchère la plus rapprochée - Q1 : Qualité de l'annonce du gagnant

P1 : Prix payé par l'annonceur - B2 : Enchère la plus haute la plus rapprochée - Q2 :Qualité de l'annonce de l'enchère la plus rapprochée - Q1 : Qualité de l'annonce du gagnant

Toute l'astuce est que par l'indicateur de qualité Google reste ainsi maître des règles du jeu. La qualité est en effet calculée par la firme elle-même. Elle repose principalement sur la pertinence de l'annonce par rapport au mot-clé sur lequel l'enchère porte, sur la qualité de la page de destination du lien et avant tout sur le pourcentage de clics sur une annonce donnée quand elle apparait sur une page. Extrait de la présentation de la firme sur l'indicateur de qualité (ici) :

Nous continuons à affiner les formules de calcul du niveau de qualité sur Google et le réseau de recherche, mais leurs principaux composants sont toujours plus ou moins les mêmes :

- l'historique du taux de clics (CTR) du mot clé et de l'annonce correspondante sur Google. Remarquez que le taux de clics sur le réseau Google a une incidence sur le niveau de qualité sur le réseau Google uniquement (pas sur Google) ;

- l'historique de votre compte, déterminé par le taux de clics de tous les mots clés et de toutes les annonces qu'il contient ;

- l'historique du CTR des URL à afficher contenues dans le groupe d'annonces concerné ;

- la qualité de votre page de destination ;

- la pertinence du mot clé par rapport aux annonces de son groupe d'annonces ;

- la pertinence du mot clé et de l'annonce correspondante par rapport à la requête de recherche ;

- les performances de votre compte dans la zone géographique où l'annonce sera diffusée ;

- d'autres facteurs de pertinence.

Pour plus de précision, on peut se reporter aussi à la vidéo où Hal Varian lui-même présente la formule (ici). Comme l'indique le journaliste de Wired, on peut reprocher à Google son arbitraire, mais pas son manque d'équité. En effet, tous les annonceurs sont soumis à la même formule qui a pour objectif de maximiser l'efficacité globale de la publicité affichée.

Et ce n'est pas tout, le succès de la firme a fait qu'il a fallu gérer des millions d'enchères et Google a inventé une nouvelle discipline, la «physique des clics», c'est-à-dire l'observation des clics sur les pages. Les chercheurs de Google ont, entre autres, construit le keyword pricing index, littéralement l'indice des prix des mots-clés, de la même façon que l'on calcule l'indice des prix de l'économie d'un pays à partir du panier de la ménagère. Il alerte la firme quand apparaissent des bulles anormales sur les prix, indication que les enchères ne fonctionnent pas correctement. La firme peut aussi corréler ces données avec celles de la température, du climat et aussi des recherches des internautes afin d'affiner ses connaissances et ses outils.

Elle utilise des dizaines de tableaux qui s'affichent en temps réel tout comme la bourse. Sur un tableau on peut surveiller les recherches, le montant de l'argent récolté, le nombre d'annonceurs, sur combien de mots-clés ils surenchérissent et le niveau de retour pour chaque annonceur. Ainsi Google, sous l'impulsion d'Hal Varian, s'est mis à recruter des économètres. L'évolution est là encore tout à fait comparable à celle qui a suivi l'informatisation des places boursières avec l'arrivée massive de mathématiciens-statisticiens à la recherche de martingales pour optimiser les gains dans ce maelstrom de cours d'actions en perpétuel mouvement.

Ainsi quand on parle d'«écosystème» pour Google, le préfixe «éco-» est plutôt celui d'économie que d'écologie : la firme a mis en place une véritable économie parallèle, autonome dont elle a fixé les règles et qu'elle contrôle étroitement. Dans cette économie ses vrais concurrents sont les indexeurs qui tentent de faire remonter les pages en optimisant au maximum leur repérage par les moteurs (SEO, Wkp), réduisant d'autant l'intérêt des liens sponsorisés.

L'Ikéa de la publicité

La seconde innovation sur laquelle je voudrais insister est l'utilisation du travail du client. Dans l'économie mise en place par la firme, la co-production avec le client est utilisée au maximum.

Ikéa, on le sait, a utilisé de façon massive la notion de servuction, c'est-à-dire, le travail avec le client. Ce dernier feuillette le catalogue, est obligé de suivre l'ensemble des produits exposés, les sélectionne et les transporte et, last but not least, construit lui-même les meubles qu'il a amené chez lui. L'ensemble a été étudié, séquence par séquence, de façon à exploiter au maximum l'activité du client. En contrepartie ce dernier dispose d'une grande liberté dans ses choix et d'un excellent rapport qualité-prix.

Mutatis mutandis, Google a utilisé la même technique pour le marché publicitaire. L'annonceur fait lui-même l'ensemble du travail qui conduira à la mise en ligne de sa publicité. Il serait ici beaucoup trop long de détailler l'ensemble des étapes, mais tout est fait pour que le client puisse optimiser l'efficacité de son message publicitaire.

Google, en plus des outils d'aide traditionnels (ici), a mis en place un centre de formation où l'on peut obtenir tous les détails sur la façon de mener une campagne publicitaire et même, si on le souhaite, passer un examen de professionnel de la publicité (là). On observera facilement que, comme pour Ikéa, chacune des séquences a été soigneusement étudiée de façon à utiliser au maximum le travail de client, et de la même façon celui-ci y gagne en liberté et en rapport qualité-prix, mesurée ici en retour sur investissement.

Actu du 11 août 2009

À compléter par la lecture de l'excellent article :

Guy Hervier, “Google devient-il un problème ?,” ITR News.com, juillet 23, 2009, ici

Actu du 8 mars 2010

Lire aussi le très polémique, mais instructif :

Publié Par J-c Féraud, “« L’objectif de Google n’est pas d’afficher l’information la plus pertinente »,” Sur Mon Ecran Radar, Mars 8, 2010, ici.

Actu du 22 septembre 2010

Voir aussi :

“Publicité : les secrets de Google France « La Social Newsroom,” ici

P1 : Prix payé par l'annonceur - B2 : Enchère la plus haute la plus rapprochée - Q2 :Qualité de l'annonce de l'enchère la plus rapprochée - Q1 : Qualité de l'annonce du gagnant

P1 : Prix payé par l'annonceur - B2 : Enchère la plus haute la plus rapprochée - Q2 :Qualité de l'annonce de l'enchère la plus rapprochée - Q1 : Qualité de l'annonce du gagnant