Par Jean-Michel Salaun le mercredi 06 juin 2012, 10:07 - Moteurs

Voici un nouveau billet pour montrer combien les avancées techniques et commerciales du web peuvent se lire au travers de la grille de la théorie du document et que celle-ci permet de souligner des impensés ou des non-dits. Cette fois je prendrai deux illustrations reliées : le web de données et la dernière annonce de Googlle, le Knowledge Graph.

Le web de données

Tim Berners-Lee dans une prestation, bien connue de la petite histoire du web, a prôné la mise à disposition libre des données, pour réaliser ce qu'il appelle le web de données, après avoir renoncé à l'appellation "web sémantique". Dans cette conférence de février 2009 à TED, je retiendrai pour mon propos le passage soulignant le rôle joué par Wikipédia (à 8mn 25s), et notamment cette diapositive.

L'image devrait éveiller quelques souvenirs aux bibliothécaires. Wikipédia, en effet, réalise une opération qui s'apparente au cataloguage, plaçant dans des champs des données descriptives du document principal pour construire une sorte de répertoire bibliographique, DBpédia, même si ici les champs sont moins formalisés que ceux des catalogueurs.

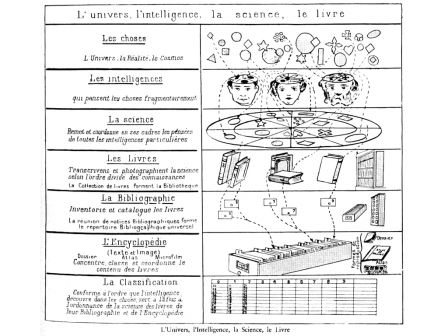

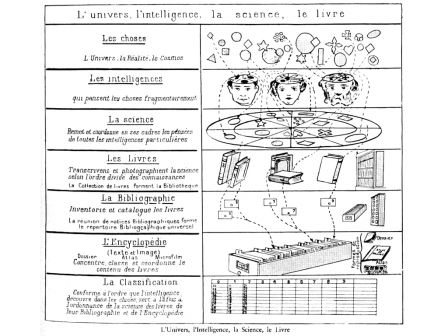

L'homologie est encore plus surprenante si l'on se souvient que P. Otlet, un des premiers théoriciens du document, avait lui-aussi proposé la réalisation d'une encyclopédie dans son rêve de cataloguer tous les documents du monde. On peut le vérifier, par exemple, sur cette image tirée de son livre testament (p.41) et bien connue des lecteurs de ce blogue :

Pourtant, il existe une différence radicale entre le projet de P. Otlet et celui de T. Berners-Lee. La documentarisation s'est déplacée. Pour le premier, l'enjeu est de récolter les documents pour les cataloguer, et l'encyclopédie n'est qu'un aboutissement, en réalité une utopie qui ne sera jamais vraiment opérationnelle. Pour le promoteur du web, cet objectif est atteint. En effet, les documents sont déjà en ligne, repérables par les moteurs de recherche, mis en place par la première étape du web. Mieux l'encyclopédie est aussi déjà là et s'enrichit dans une dynamique continue selon la logique de la seconde étape du web (Wikipédia est une figure emblématique du web 2.0).

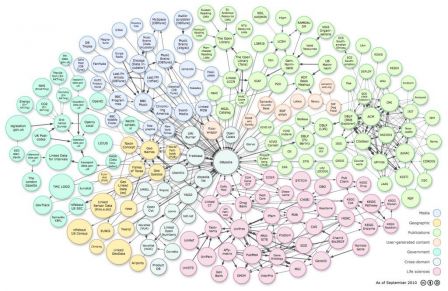

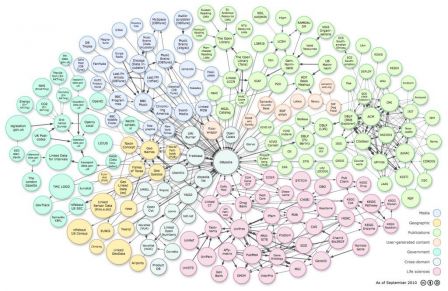

L'enjeu est alors différent, conforme à l'évolution de la société - nous ne sommes plus à l'époque du triomphe de la science positive. Il s'agit de reconstruire des documents à partir des requètes des internautes en se servant comme ossature logique des données récoltées notamment dans l'encyclopédie et aussi dans d'autres bases coopératives comme Freebase. DBpédia est considérée par les chercheurs comme un noyau pour un web de données ouvertes. Tim O'Reilly, l'inventeur de l'expression Web 2.0 souligne pour sa part que Freebase constitue le pont entre l'intelligence collective issue de la base du web 2.0 et le monde plus structuré du web sémantique (ici trad JMS).

Nous sommes toujours dans une sorte de cataloguage, mais les métadonnées ne servent plus à retrouver un document, "libérées", rendues interopérables et traitables par les logiciels du web de données, elles se détachent de leur document d'origine pour se combiner et produire de nouveaux documents, nous dirons des néodocuments. A cet ensemble premier, peut alors se relier nombre de bases de toutes natures, libérées elles-aussi, mais ordonnées grâce à l'ossature initiale. Ci-dessous la version de sept 2011 du graphe ainsi constitué (voir ici pour naviguer dessus)

L'encyclopédie Wikipédia est un outil privilégié pour construire l'armature de ce nouvel ensemble car elle a vocation à être neutre et universelle. Tout se passe comme si les wikipédiens avaient catalogué les entrées de l'encyclopédie en ligne et que la mise en réseau de cette classification universelle pouvait autoriser la construction d'un nouveau monde documentaire, celui du néodocument servant sans doute moins à transmettre et prouver, comme son ancêtre, mais plus à échanger et convaincre dans une relation utilitariste.

Et en trichant un peu, on peut modifier et compléter alors le tableau de P. Otlet pour bien signifier la continuité historique de la logique documentaire du web, y compris pour ses applications les plus contemporaines. Peut-être que d'autres, plus doués que moi en graphisme, auront le plaisir de développer les pictogrammes...

Le Knowledge Graph

Google a annoncé tout récemment l'intégration d'une dimension sémantique dans son moteur de recherche, baptisée Knowledge Graph (communiqué, pour une présentation rapide en fr voir Abondance, et une analyse voir Affordance). La firme fait ici un pas important vers le web de données.

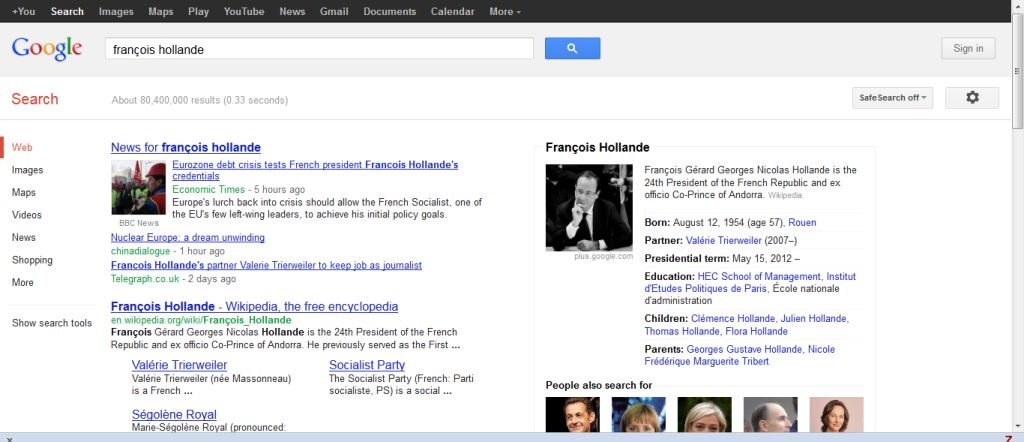

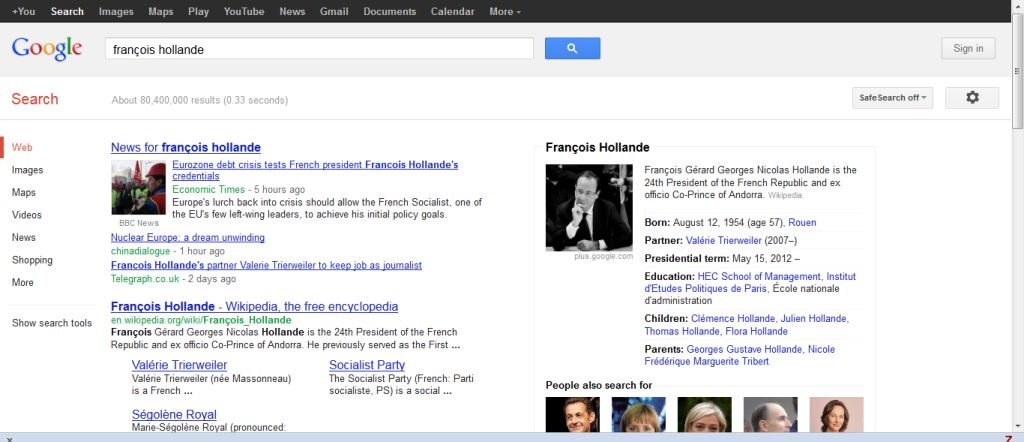

Le principe du service est de proposer parallèlement aux réponses traditionnelles aux requêtes (liste de liens vers des documents pertinents récupérés par le PageRank), des informations construites à la volée donnant des éléments de contexte et, le cas échéant, la réponse elle-même. Google a indiqué qu'il avait soigneusement retravaillé son algorithme pour puiser des informations dans des bases de données comme Freebase ou Wikipedia afin de donner du contexte aux mots. (Les Echos).

Là encore, la continuité avec l'histoire documentaire est manifeste. Déjà comme l'indique Tim Berners-Lee lui-même, Google avait permis au premier web de devenir une bibliothèque : dès le développement du Web, ses détracteurs ont souligné qu’il ne pourrait jamais être une bibliothèque bien organisée, que sans base de données centrale et sans structure arborescente, on ne pourrait jamais être sûr de tout trouver. Ils avaient raison. Mais la puissance d’expression du système a mis à la disposition du public des quantités importantes d’informations et les moteurs de recherche (qui auraient paru tout à fait irréalisables il y a dix ans) permettent de trouver des ressources. (citation extraite de l'article qui lance le web sémantique, trad fr ici). Avec ce nouveau service, Google reconstruit à la volée un néodocument correspondant au contexte de la requête et l'affiche sur la page de réponse. Il participe ainsi directement à la suite de l'aventure, le web des données ou le web 3.

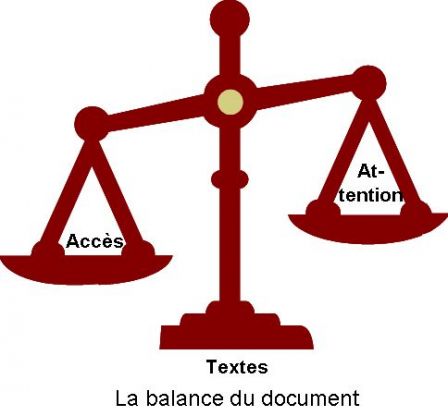

L'avenir nous dira quel sera l'intérêt et le succès de ces néodocuments, qui remplaceront sans doute quelques documents traditionnels et ouvriront peut-être aussi d'autres avenues. Mais avec l'arrivée de Google dans le paysage du web de données, il est déjà possible de pointer un non-dit de cette aventure. Pour cela l'analyse en trois dimensions du document (vu, lu, su) est éclairante. J'ai déjà eu l'occasion de dire que les trois étapes de l'histoire du web privilégiaient chaque fois une des dimensions : la forme, le repérage, le vu avec le premier web, celui du document ; le medium, la transmission, l'échange, le su avec le web 2.0, celui du partage ; le sens, le contenu, le lu avec le web de données, l'ex-web sémantique. Tim Berners-Lee et ses collègues du W3C se sont surtout intéressés aux webs 1 et 3, considérant le 2 comme simplement une extension naturelle du 1 et repoussant les questions sociales dans les dernières couches logicielles du ''cake''. Pourtant le carburant économique du web, nous le savons, est bien dans l'économie de l'attention, c'est-à-dire dans la deuxième dimension.

Déjà dans le premier web pris selon cette dimension, Google et Wikipédia n'étaient pas sans connivence (ici). On peut même prétendre que sans Google, Wikipédia n'aurait pas eu le même succès et que sans Wikipédia, Google n'aurait pas eu la même saveur. Mieux, la tentative de Google de construire sa propre encyclopédie a tourné court, comme si le succès de la coopération dans Wikipédia impliquait l'affichage du désintéressement. Les deux services sont alors complémentaires, fondant un écosystème au sens fort du terme basé sur l'économie de l'attention.

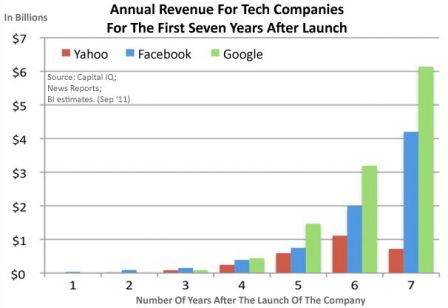

Il est un peu tôt pour savoir ce que donnera le nouveau service de Google en termes documentaires, mais on peut déjà avoir une petite idée de son impact sur l'économie de l'attention. Comme l'explique O. Andrieu sur ''Abondance'', Il semble déjà que l'impact sur le nombre de requêtes soit important. Il ajoute : Cela est logique dans le sens où le "Knowledge Graph" propose de nombreux liens concernant l'objet de la requête et de l'"entité nommée" détectée. D'ailleurs, cela pourrait clairement être à l'avantage de Google : l'internaute tape une requête sur la page d'accueil du moteur, obtient les résultats du Knowledge Graph, reclique sur les liens de recherche proposés, etc. Bref, autant de possibilité d'afficher des Adwords pour Google et autant de clics publicitaires potentiels !. De plus le processus tend à réduire l'impact des stratégies de référencement des sites au profit de l'achat de mots-clés, ce qui est doublement profitable pour Google. Inversement, il tend à faire monter dans les réponses les rubriques de Wikipédia...

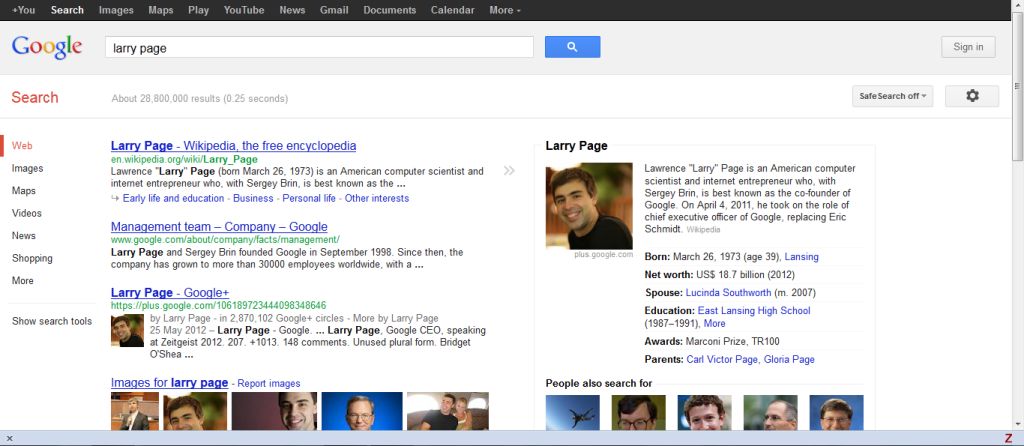

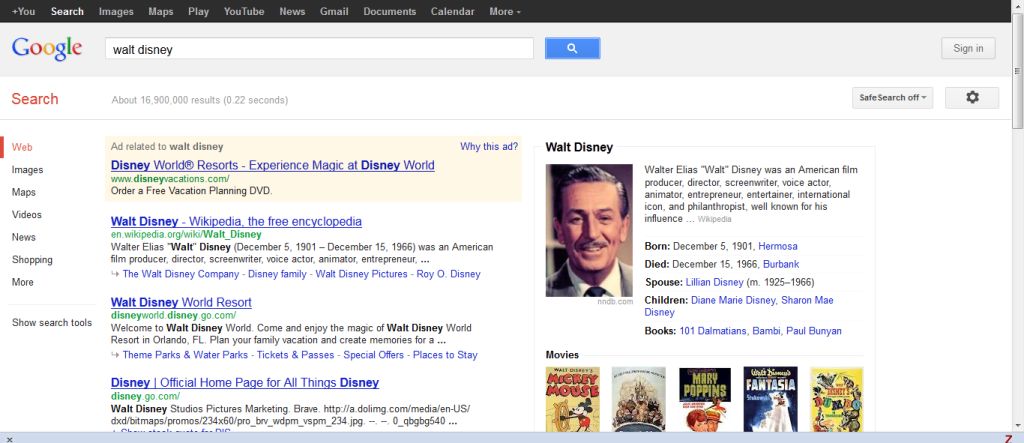

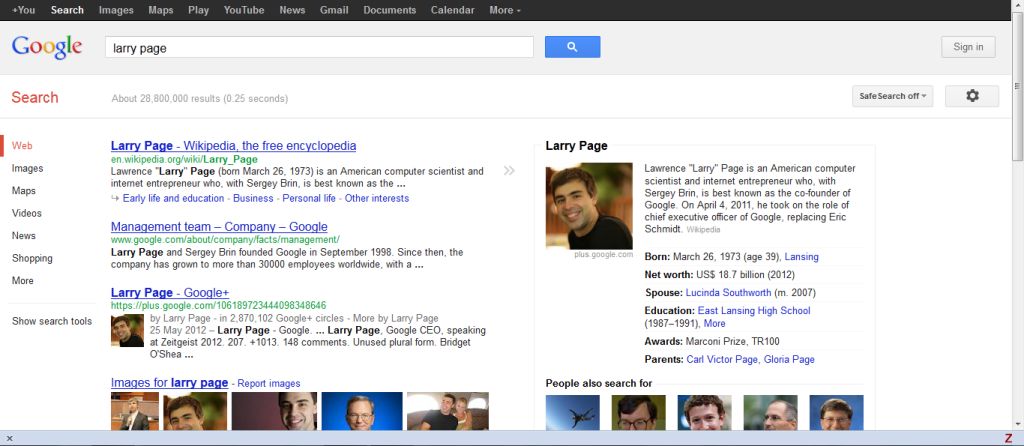

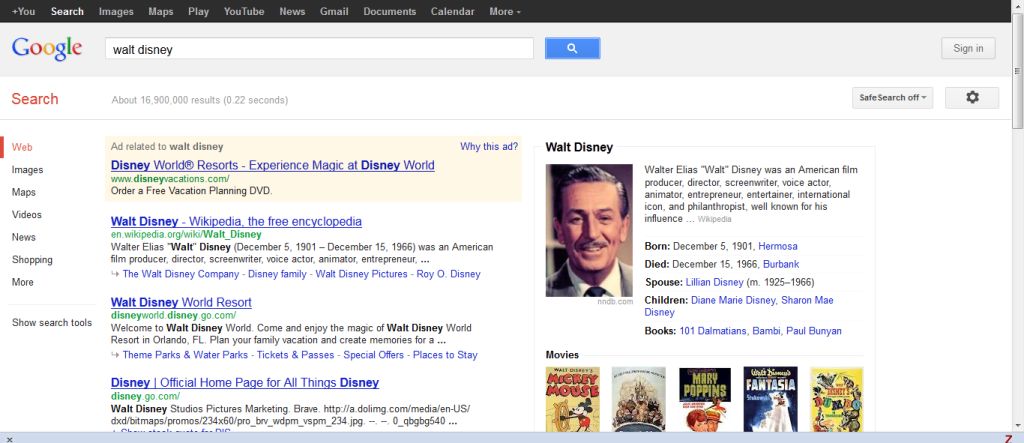

Pour illustrer l'importance du changement, voici trois requêtes faites sur Google.com, telles qu'elles apparaissent en plein écran sur ma machine. Le néodocument généré automatiquement se trouve sur la droite. Le lecteur conclura de lui-même.

29 juillet 2012

ITW d'Emily Moxley, responsable du Knowledge Graph chez Google :

« How Google Organizes the World: Q&A With the Manager of Knowledge Graph ». ReadWriteWeb, 26 juil 2012 .

Extraits (trad JMS) :

ReadWriteWeb: Quel est l'objectif de Google avec le Knowledge Graph ?

Emily Moxley : Il s'agit de cartographier le monde réel en quelque chose que les ordinateurs puissent comprendre. Cela consiste à prendre des objets du monde réel, à comprendre ce que sont ces choses et quelles sont les choses importantes à leur sujet, ainsi que leurs relations à d'autres choses. C'est la partie que je trouve la plus fascinante : Quelle est la relation entre toutes ces différentes choses ?

(..)

RWW: Comment les choses sont ajoutées au Knowledge Graph ? Apprend-il de noueaux concepts des usagers ?

EM: Il est actualisé très activement par les employés de Google. Avant, Metaweb (JMS : qui a développé Freebase, rachetée par Google) était cette base d'entités et de faits et les employés de cette société utilisaient beaucoup leur intuition sur ce qui importait pour les usagers et sur quelle information aller chercher. Depuis qu'ils ont été rachetés par Google, Google dispose de tous ces usagers cherchant de l'information,(...) Google sait que les gens qui cherchent une chose en cherchent aussi d'autres. Ainsi on peut voir des relations intéressantes en regardant les sessions agrégées des usagers. Une des prochaines étapes est effectivement d'expliquer ces relations fortuites. Qu'est-ce qui est semblable à ce groupe d'acteurs ? Qu'est-ce qui explique dans ce film que les gens le recherche souvent avec ces cinq autres ? (..)

RWW: Est-ce que travailler avec des sources de données extérieures comme le CIA World Factbook ou Wikipedia, est plus compliqué que travailler avec les données de Freebase ?

EM: Il y a un vrai défi avec les sources de données externes, c'est la correspondance (reconciliation). Même en interne, nous venons d'acheter Metaweb il y a deux ans, et nous avions déjà une énorme quantité de données dans certains domaines, les données des livres et cartes locales sont les principaux. Ces deux étaient bien plus importants que Freebase. Ils disposaient de beaucoup plus d'entités et d'informations. Les faire correspondre à la nouvelle organisation des données fut un gros défi. (..) Ce n'est pas plus difficile avec des éléments extérieurs qu'internes.

RWW: Mais devez-vous corriger des choses ? Comment choisissez-vous si c'est plutôt le CIA World Factbook ou Google qui a raison ?

EM: Volontairement, nous essayons de nous en tenir à des choses définitivement vraies - factuelles - pas des choses sujètes à spéculation ou opinion, et nous faisons des erreurs du côté des faits. Aussi si cela est sujet de controverse, nous pourrions décider de ne pas le montrer (dans la Knowledge box). (...)

Avec Knowledge Graph l'objectif est différent (de la recherche classique). Il s'agit d'obtenir une information le plus rapidement possible, mais aussi de vous donner des informations que vous ne saviez même pas que vous recherchiez. (...)

9 août 2012

La présentation officielle en vidéo du KG. Cela va très vite, la recherche par image a été intégrée.

30 août 2012

Il semble que les infos de profil de Google + soient intégrées maintenant :