Par Jean-Michel Salaun le jeudi 16 octobre 2008, 23:49 - Cours

(Repéré sur Numérama grâce à la veille de Silvère Mercier que je ne remercierai jamais assez pour son travail qui me sert tous les jours !)

Avant d'être récipiendaire du prix Nobel d'économie, Paul Krugman avait publié à la fin du printemps un éditorial dans le New-York Times, reprenant l'argument classique selon lequel les documents étant devenus des biens publics grâce au Web, un prix de marché n'était plus possible, par contre, il était possible d'utiliser la puissance de résonance pour valoriser des services associés. Il est présomptueux et imprudent de contredire un prix Nobel, mais après tout un blogue est là pour lancer des idées, même à contre-courant de la plupart des confrères. Et, quitte à prendre une volée de bois verts, j'affirme qu'en l'occurrence il se trompe. L'erreur est d'autant plus gênante que, son auteur ayant acquis l'autorité que lui confère le plus prestigieux des prix scientifiques, elle risque de passer pour une vérité incontestable.

Paul Krugman, “Bits, Bands and Books,” The New York Times, Juin 6, 2008.

Extraits (trad. JMS) :

En 1994, une de ces gourous, Esther Dyson, a fait une prédiction saisissante : la facilité avec laquelle le contenu numérique pouvait être copié et diffusé pourrait finir par obliger les entreprises qui vendent les produits de l’activité des créateurs à un prix très bas, ou même de les donner. Quel que soit le produit, logiciel, livre, musique, film, le coût de création devrait être récupérer indirectement. Les entreprises devraient «distribuer gratuitement la propriété intellectuelle pour vendre les services et des contacts». (..)

Évidemment, si les e-books deviennent la norme, l’industrie de l’édition telle que nous la connaissons pourrait dépérir complètement, Les livres pourraient servir principalement de matériel promotionnel pour d’autres activités des auteurs, comme des séances payantes de lecture. Bon, si cela a suffi à Charles Dickens, je suppose que cela me suffira.

Car la stratégie consistant à brader la propriété intellectuelle pour que les gens achètent tout ce qu’il y a autour ne marchera pas de façon équivalente pour tout. Pour s’en tenir à un exemple évident et douloureux : l’organisation de la presse, y compris ce journal, a passé des années à essayer de faire passer ses nombreux lecteurs en ligne par un paiement adéquat, avec un succès limité.

Mais, ils devront trouver la solution. Progressivement, tout ce qui peut être numérisé le sera, rendant la propriété intellectuelle toujours plus facile à copier et toujours plus difficile à vendre pour plus qu’un prix symbolique. Et nous devons trouver des modèles d’affaires et une économie qui tiennent compte de cette réalité.

La première erreur est de considérer que l'articulation entre le contenant et le contenu telle qu'elle est réalisée sur le Web et donc le partage de la valeur qui l'accompagne, est une donnée hors du champ de l'analyse et non un construit social significatif pour celle-ci. En réalité, l'abondance de biens informationnels gratuits valorise ceux qui vendent de l'accès, soit par des abonnements au réseau, soit par des machines. C'est une erreur de penser que les internautes ne dépensent rien pour ces produits, ils dépensent, et parfois beaucoup, en machines et abonnements, c'est à dire pour les contenants.

C'est aussi une erreur découlant de la précédente de penser que c'est la seule voie possible. Deux exemples démontreront le contraire :

- Lorsque France-Télécom (à l'époque DGT) lança le Minitel et la télématique (Wkp), elle distribua gratuitement les terminaux en instaurant un système de micropaiement sur les services. Ce modèle d'affaires fut très rentable pour les producteurs de contenu (et, parait-il, il reste encore rentable dans quelques micro-créneaux). Cette stratégie est le parfait inverse de celle de Apple sur la musique avec le iPod.

- La Corée du Sud avec le réseau Naver (ici) a mis en place un réseau payant, véritable place de marché où les transactions sur le contenu se font quotidiennement dans le respect de la propriété intellectuelle.

La stratégie de Kindle de Amazon va dans le même sens. Je suis moins sûr que P. Krugman qu'elle soit vouée à l'échec et, si elle l'était, cela viendrait moins d'une loi économique générale sur l'échange de contenus que d'une stratégie qui favorise, avec la complicité intéressée mais inconsciente des «gourous du Web», les industries du contenant.

La seconde erreur importante est de croire que le Web produit une rupture radicale par rapport à la situation antérieure. Il existait déjà des industries de contenu accessibles gratuitement aux documents facilement copiables, et pas des moindres : la radio et la télévision. Il existait aussi des institutions où les documents étaient partagés : les bibliothèques. Pour les unes et les autres, des modalités ont été trouvées, parfois après de laborieuses négociations, pour préserver la propriété intellectuelle et garantir un financement du contenu. On pourrait discuter de ce partage, mais c'est un autre débat.

Sans doute, le Web est un formidable outil de résonance, tout comme d'ailleurs la radio-télévision, mais rien n'interdit de trouver des modalités de rétribution des ayant-droits, sinon le dialogue de sourds qui s'est installé entre des détenteurs de droits, trop gourmands et incapables de comprendre l'organisation du Web-média, et les internautes militants incapables quant à eux d'imaginer que celui-ci puisse dépasser son adolescence rebelle. Refuser cette possibilité, c'est alors refuser la capacité au Web de devenir un média à part entière, tout en faisant le lit de quelques acteurs dominant qui accaparent à leur seul profit ou presque la vente d'attention créée par les contenus, au premier chef, bien sûr, Google.

Là encore, c'est donc une erreur que de croire que le Web tuera nécessairement les médias plus anciens, même si, clairement, le Web-média en prenant brutalement place parmi ceux-là réduit leur place et donc globalement leurs revenus, sans doute de façon inégale suivant les médias. Prenons là aussi deux exemples rapidement :

- Dans la vidéo, malgré les téléchargements sauvages, la propriété intellectuelle continue de régler les positions sur le Web, comme le montrent les négociations engagées par YouTube avec les réseaux de télévision, les producteurs de séries ou encore les détenteurs de droits sportifs, ou comme le montrent les difficultés de la station Web Joost.

- Dans la musique, l'annonce récente des résultats de l'expérience du groupe RadioHead où le paiement du téléchargement était laissé à la discrétion des internautes sont impressionnants. Au total, Radiohead a écoulé à ce jour 3 millions d'exemplaires de In Rainbows, sous forme de CD (1,75 million), de boîtiers de luxe vendus par correspondance (100 000) ou en téléchargement. Il faut y ajouter les droits sur les passages en radio et 1,2 millions de personnes à leurs spectacles. La résonance a été très forte, mais elle a aussi favorisé les formes les plus classiques de la vente de contenus.

Les étudiants du cours auront retrouvé le long de ce billet des éléments de la séquence 1 (l'argument de P. Krugman), de la séquence 2 (ma première réfutation) et de la séquence 3 (ma seconde réfutation).

Complément du 18 octobre 2008

Repéré grâce au commentaire de A. Pierrot, merci à lui :

PREMIERS RESULTATS :

OBSERVATOIRE DES DEPENSES MEDIAS ET MULTIMEDIAS, Communiqué (Médiamétrie, Octobre 15, 2008).

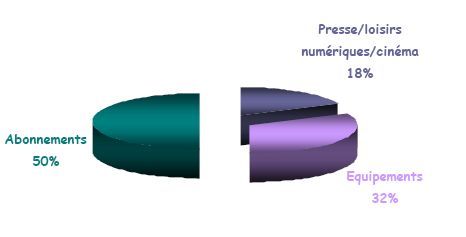

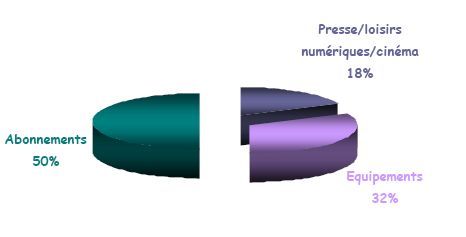

Voici la répartition du budget d'un ménage français pour les médias et le multimédia sur une année en 2007-08. La dépense totale est de 2270 Euros et pour les familles ayant des enfants (11-24 ans) : 2920 Euros.

Édifiant..