Après Apple et Google, voici donc le troisième billet illustrant la théorie du document sur la stratégie d'une firme : Facebook. Bien évidemment après la forme privilégée par Apple, le texte par Google, le réseau social s'appuiera principalement sur la troisième dimension : le médium.

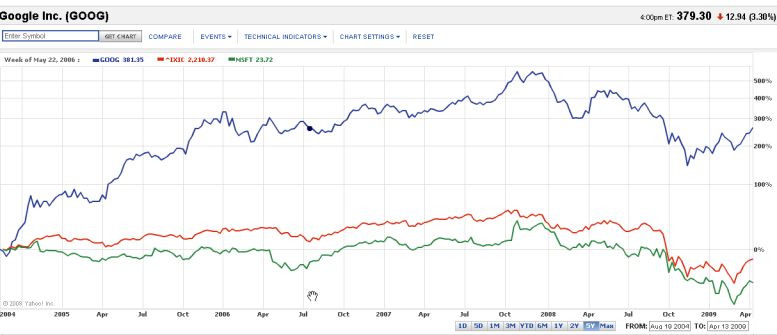

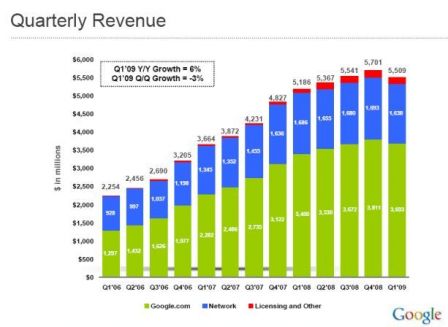

Il est délicat de mesurer l'économie de Facebook, car la firme n'étant pas cotée en bourse on ne dispose pas de chiffres certifiés. L'année dernière, elle a annoncé qu'elle avait, pour la première fois, équilibré ses comptes sans autre précision. Les observateurs parlent d'un chiffre d'affaires entre 500 M et 1 Mds de $ en 2009 et qui pourrait osciller en 2010 entre 1 et 2 Mds de $. Ces chiffres, pour peu qu'ils soient exacts, paraissent impressionnants, pourtant ils sont moins élevés que Google dans le même délai :1,5 Mds après 5 ans et 3,2 l'année suivante (23,6 Mds de CA et 6,5 Mds de bénéfices en 2009), et finalement très modestes si l'on considère que Facebook.com a dépassé Google.com sur le trafic internet US en mars 2010 (Hitwise). Un calcul rapide et approximatif chiffre à 7,87 Mds de $ le chiffre d'affaires de Google.com sur le seul marché US pour l'année 2009.

Facebook est un immense succès public, mais n'a clairement pas encore réussi à monétiser son audience. Il suffit de comparer en les feuilletant les pages destinées aux annonceurs de Facebook (ici) avec celles de Google là pour comprendre que l'on ne joue pas dans la même cour.

Une économie spéculative

D'autres chiffres astronomiques font du jeune fondateur Marc Zuckerberg un des hommes les plus riches du monde (Forbes), mais cette richesse est basée sur une appréciation des marchés financiers qui ont depuis longtemps perdu la mesure de l'économie réelle, tout particulièrement dans le numérique. Ils font un autre raisonnement déconnecté du chiffre d'affaires et des bénéfices de la firme, basé sur la capacité à revendre ses parts à un prix plus élevé que celui de leur achat initial.

Ainsi par exemple, un fonds de capital risque russe, Mail.ru, cherche aujourd'hui à valoriser sa participation dans Facebook en vendant à un prix élevé ses propres actions là et là). On trouvera une seconde illustration dans l'exposé de la stratégie d'investissement dans Facebook d'un autre fond, GreenCrest Capital LLC, qui cherche à racheter des actions aux anciens employés du réseau (WSJ). Même si elles sont rapportés par un journal du groupe Murdoch, concurrent direct du réseau avec MySpace les explications sont éclairantes. Extraits (trad JMS) :

Puisque certains de ces fonds ne sont pas sanctionnés par les starts-up dans lesquelles ils ont investi, ils n'ont pas accès aux informations de gestion, financières et autres. Cela rend ces investissements risqués, disent des observateurs professionnels de l'investissement. Les investisseurs potentiels peuvent obtenir des compte-rendus du conseil d'administration et quelques informations financières limitées d'actionnaires vendeurs, mais pas beaucoup plus. (..)

Le prix des actions Facebook sur le marché secondaire a considérablement augmenté, dit M. Halpert (un des directeurs du fond), d'environ 5 $ un an et demi auparavant il est aujourd'hui à environ 70 $, avant le récent fractionnement d'actions de 1-pour-5, ce qui valoriserait de l'entreprise à 33 milliards de dollars. Cette évaluation serait l'ordre de grandeur pour les actions de Facebook sur le second marché, selon une personne proche de la négociation en cours sur ce service.

La réalité économique de Facebook est dans cette économie spéculative. Les chiffres exponentiels de son audience, complaisamment relayés, permettent de faire monter les enchères. On ne parle toujours pas d'introduction en bourse et on s'attend à une prochaine levée de fonds qui sera d'autant facilitée que sa valorisation sera élevée.

L'économie de Facebook signifie souvent l'économie générée par ceux qui utilisent le réseau comme plateforme pour développer leurs propres activités rémunératrices (VisualEconomics et pour la principale application Zynga là). Les chiffres présentés sont parfois aussi spectaculaires en terme d'audience, mais pratiquement jamais exprimés en chiffre d'affaires ou bénéfices. Il y a ainsi comme une connivence dans la surenchère spéculative entre le réseau et les producteurs d'application, l'écosystème.

Cette situation n'est pas sans rappeler le début du millénaire, juste avant l'éclatement de la bulle internet. Il ne faudrait pas pour autant sousestimer le succès public de Facebook ni dénier à cette économie spéculative la capacité à construire de la valeur. Contrairement aux starts-up de l'épisode malheureux précédent, les réseaux sociaux produisent une activité. Ainsi selon la dernière enquête IFOP, pratiquement tous les Français (98%) connaissent Facebook et 43% ont un compte (ici). Même si un pourcentage sensiblement moindre y est actif, bien des entreprises rêveraient d'un tel succès.

L'individu-document

Difficile alors de garder la tête froide et de produire une analyse lucide du phénomène. Sans prétendre y arriver complètement, je voudrais suggérer que la théorie du document peut donner quelques clés de compréhension.

Facebook, comme les autres réseaux sociaux, inverse les propriétés documentaires du web. Les humains n'y recherchent pas des documents, les documents ne sont plus que des vecteurs qui relient entre eux des humains ou d'autres entités personnalisées (marques). Ainsi le réseau polarise l'ordre documentaire sur sa troisième dimension : le médium.

Mieux, les techniques du web documentaire servent à indexer les individus pour les décrire et les repérer, non seulement dans leur « forme », c'est-à-dire leur identité et caractéristiques, mais aussi dans leur « texte », leurs comportements et intentions. On pourrait dire comme Olivier Ertzscheild « L’homme est un document comme un autre » (ici, voir aussi mon billet). Dès lors toute la productivité d'un système documentaire est déplacée sur un terrain, la communication entre les hommes, où elle était jusqu'à présent peu utilisée faute d'outils adéquats (courrier postal, téléphone..).

La radicalisation de l'homologie individu-document, modifie l'ordre traditionnel des documents qui est alors soumis à celui des individus. L'individu-document est moins stable que l'objet-document. La versatilité et la réactivité des clivages sociaux s’introduisent dans les arcanes des logiques documentaires, qui, si elles ne les ignoraient évidemment pas, avaient auparavant plus de recul et d’inertie. On pourrait dire que l'ordre documentaire s’apparente ici celui de la mémoire vive, avec ses emballements et ses oublis.

La valorisation économique de ce positionnement se cherche aujourd'hui sur deux marchés : la publicité et la revente des données comportementales. Sur l'un et l'autre elle rencontre des difficultés.

Facebook cherche à utiliser sa maîtrise du «graphe social», c'est à dire l'empreinte des liens entre les personnes, comme un avantage concurrentiel décisif pour valoriser la vente d'attention. Vous pouvez cibler votre publicité par géographie, sexe, âge, mots-clés, situation amoureuse, emploi, lieu de travail ou établissement scolaire. Lorsque vous choisissez vos critères de ciblage, Facebook affiche le nombre approximatif d’utilisateurs concernés, peut-on lire sur les pages réservées aux annonceurs. Ce ciblage peut faire rêver les annonceurs. Il suppose néanmoins que les membres du réseau aient renseigné de façon sincère ces critères et acceptent de partager ces informations, c'est à dire qu'ils se soient auto-documentarisés. Nombreuses ont été les tentatives de la firme pour «obliger» les membres à diffuser leurs profils et nombreuses ont été les polémiques. Il ne s'agit pas de maladresses, mais bien d'un tâtonnement pour trouver un équilibre acceptable entre la protection des individus et les nécessités du commerce. Reste à savoir s'il existe vraiment.

Les données comportementales sont récoltées par les traces de navigation des internautes. Il s'agit cette fois d'une documentarisation automatique. Un marché souterrain de ces données, mariant les premières et transversal aux réseaux s'est mis en place non sans ambiguïtés (là).

Aujourd’hui le débat éthique est très vif. Jusqu’à présent seules les organisations policières confondaient l’ordre documentaire et l’ordre social pour contrôler ce dernier. Cela n'était acceptable qu'avec des normes sociales explicites et acceptées sous le contrôle strict d'un État démocratique (là), sans pour autant éviter de nombreux dérapages. L'idéologie libertarienne des fondateurs de Facebook accentue encore le malaise (là).

Même en faisant abstraction de ce débat, la valeur économique de cette stratégie n’est pas encore vraiment démontrée. On en perçoit les potentialités qui font rêver les uns, cauchemarder les autres. Certaines rentabilisations pointent, mais il n’est pas évident que l’homologie individu-document soit à terme éthiquement supportable et économiquement rentable.

Actu du 31 octobre 2010

Voir aussi : 1. “Social Media and Revenues: Where’s the Profit?,” Master of Media, Octobre 31, 2010, ici.

Actu du 22 novembre 2010

Pour s'interroger sur quelques conséquences de la redocumentarisation des humains par Facebook :

Zadie Smith, Generation Why?, The New York Review of Books, November 25, 2010 là

Critique en français ici

Actu du 18 déc 2010

Quelques éléments sur les revenus 2010 de Facebook dans Inside Facebook ici.

Voir aussi Numerama,(là), très optimiste.. et maniant curieusement les chiffres.

Actu du 3 fév 2011

Voir aussi cette infographie de Google vs Facebook. Je ne suis pas sûr des chiffres financiers à vérifier ici

Actu du 31 déc 2010

Bonne analyse détaillant différents mode de calcul de la valorisation :

Robert Cyran et Rob Cox, “Will 2011 be the year that Facebook’s value gets real?,” Reuter Breakingviews, Décembre 28, 2010, ici.

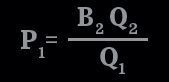

P1 : Prix payé par l'annonceur - B2 : Enchère la plus haute la plus rapprochée - Q2 :Qualité de l'annonce de l'enchère la plus rapprochée - Q1 : Qualité de l'annonce du gagnant

P1 : Prix payé par l'annonceur - B2 : Enchère la plus haute la plus rapprochée - Q2 :Qualité de l'annonce de l'enchère la plus rapprochée - Q1 : Qualité de l'annonce du gagnant Diaporama complet

Diaporama complet