Sortie le 10 février 2012 en librairie, et j'espère avant en ebook.

(...) Le premier chapitre rappelle que la bibliothèque qui collecte les documents est, et de beaucoup, le plus ancien des médias. Si le numérique a ébranlé son modèle, il n’est pas le premier à l’avoir fait. L’imprimerie à caractères mobiles l’avait déjà privée de la fonction de reproduction et circulation des livres. Inversement, la bibliothèque a été, consciemment ou non, une des premières sources d’inspiration pour le développement du Web et, ironiquement, certains des acteurs du numérique ont réussi à faire de l’exploitation de son modèle une activité très profitable alors que celui-ci était depuis toujours fondé sur un écosystème non marchand.

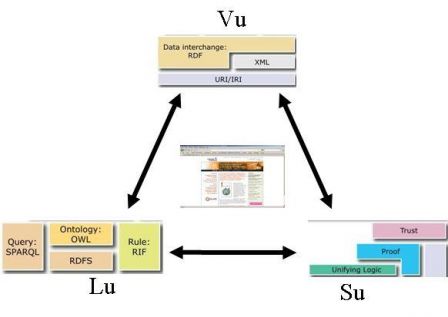

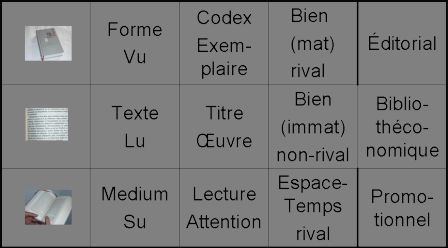

Le deuxième chapitre revient sur la notion de document en montrant que si ses deux fonctions, transmettre et prouver, sont très anciennes, le document n’est devenu un objet familier qu’au XIXe siècle. Son émergence est contemporaine du développement de la science moderne. Son apogée coïncide avec la systématisation du modèle de la bibliothèque. Comme souvent dans les sciences humaines et sociales, c’est au moment où l’objet semble s’échapper que les efforts pour le comprendre sont les plus grands. Analysant l’éclatement du document au travers du numérique, un collectif de chercheurs, signant du pseudonyme Roger T. Pédauque, a proposé d’éclairer la nature du document à partir de trois dimensions : la forme, le texte ou le contenu, et le médium ou la transmission ; le « vu », le « lu » et le « su ». Cette partition servira de canevas pour la réflexion dans la suite du livre.

Le troisième chapitre montre combien l’organisation documentaire, hiérarchique et systématique, issue du XIXe siècle, a dominé le XXe en se perfectionnant, miroir d’une société issue de la révolution industrielle et scientifique. La construction du Web sous l’impulsion du consortium W3C a conduit à une réingénierie documentaire radicale qui met aux commandes l’internaute et modifie le document dans ses trois dimensions. Poussé au bout, le processus renverse notre régime de vérité en faisant de l’individu lui-même un document. Cette réingénierie documentaire est en phase avec les valeurs émergentes d’une société postmoderne.

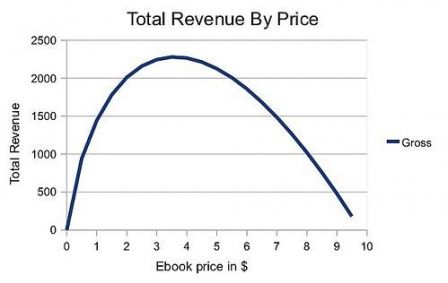

Pour les documents publiés, trois marchés, et trois seulement, qui correspondent aux trois dimensions du document, ont été ouverts : l’édition avec la vente de biens (forme), la bibliothèque avec la vente de services d’accès (texte) et enfin le spectacle avec la vente d’attention (médium). Le Web s’insère entre la radiotélévision et la bibliothèque, comme la presse s’était insérée entre l’édition et le spectacle au XIXe. De l’édition à la radiotélévision en passant par la presse et le Web, on observe une modification progressive de la gestion de l’espace-temps de la production-consommation des documents publiés, régulée par l’organisation tarifaire. De plus, le Web s’impose aux médias et les transforme en industries de la mémoire, par leur accès transversal et leur archivage permanent. Dès lors, il est possible de reconsidérer les catégories traditionnelles de l’économie de la culture pour mettre en avant l’importance de celle du document. Cette relecture des industries culturelles à partir d’une entrée documentaire est l’objet du quatrième chapitre.

L’analyse tridimensionnelle du document permet enfin (cinquième chapitre) d’éclairer les stratégies des principaux acteurs industriels du Web et de les comparer avec les intentions des ingénieurs et les souhaits des internautes militants, soulignant la distance entre les utopies et les réalisations industrielles. Des verrouillages et des affermages ont été mis en place en privilégiant, là encore, l’une ou l’autre dimension du document : la forme, en maîtrisant les objets (Apple), le contenu, en navigant au travers des textes par des « lectures industrielles » (Google), ou encore la relation (Facebook), de façon à accaparer avec plus ou moins de succès le maximum de profits.

Le livre se conclut par le besoin de nouveaux professionnels de l’information, capables de comprendre les mouvements en cours pour construire et gérer les nouvelles infrastructures documentaires. Les iSchools en Amérique du Nord forment aujourd’hui des professionnels compétents aussi bien en informatique qu’en sciences de l’information. On appelle parfois ces nouveaux professionnels des « architectes de l’information ». En français, je suggère d’utiliser le terme d’« archithécaires » pour signifier ces nouvelles compétences, puisant leurs racines dans les savoirs bibliothéconomiques, mais les dépassant très largement.

En résumé, à partir de l’histoire du document et de son analyse tridimensionnelle, le livre propose un éclairage différent de ceux qui se discutent sur le Web. On y constate que cette invention du Britannique Tim Berners-Lee prend la suite des efforts d’indexation systématique lancés à la fin du XIXe, modifiant le document lui-même dans ses trois dimensions : la forme, le contenu et la fonction de transmission. Le Web est alors un média comme un autre, s’inspirant du modèle de la bibliothèque et de celui de la radiotélévision pour répondre aux aspirations documentaires d’une société qui a changé en profondeur. Les anciens médias eux-mêmes élargissent leur vocation en devenant des « industries de la mémoire » par l’archivage numérique continu et public de leur production. Les nouveaux venus, Apple, Google, Facebook, privilégient chacun une dimension différente du document pour tenter de prendre une position dominante dans la construction d’un « néodocument ». (...)