Par Jean-Michel Salaun le mardi 31 août 2010, 09:00 - Éco

Le Wall Street Journal a publié cet été une série de cinq articles sur la surveillance et le repérage des internautes. Ces articles sont aussi importants par les informations qu’ils apportent, que par le statut du journal qui les publie.

1. Julia Angwin, “The Web's New Gold Mine: Your Secrets,” wsj.com, Juillet 30, 2010, rub. What They Know, ici.

2. Nick Wingfield, “Microsoft Quashed Effort to Boost Online Privacy,” wsj.com, Août 2, 2010, rub. What They Know, ici.

3. Justin Scheck, “Stalkers Exploit Cellphone GPS,” wsj.com, Août 3, 2010, rub. What They Know, ici.

4. Emily Steel et Julia Angwin, “On the Web's Cutting Edge, Anonymity in Name Only,” wsj.com, Août 4, 2010, rub. What They Know, ici.

5. Jessica E. Vascellaro, “Google Agonizes on Privacy as Ad World Vaults Ahead,” wsj.com, Août 10, 2010, rub. What They Know, ici.

Voici quelques notes et commentaires article par article. Attention, il s’agit de ma lecture et de mon interprétation des articles et non d’un compte-rendu fidèle, j’y ai ajouté commentaires, liens et réflexions de mon cru. Le sous-titre représente la principale leçon que j’en ai tirée.

1. L’économie souterraine du ciblage

Le WSJ s’intéresse dans cet article introductif aux logiciels espions.

Du côté technique, les initiés n’apprendront pas grand-chose. J’avais déjà rendu compte d'une enquête sur les 50 sites les plus populaires des US (là où on trouvera aussi le lien vers l'enquête de AT&T sur 1.000 sites populaires citée dans l'article). Le journal a fait une expérience similaire avec un ordinateur test. Il a constaté que les 50 sites les plus fréquentés avaient déposé 3184 éléments de surveillance au total, la plupart du temps sans prévenir, une douzaine de sites en a déposé plus de cent, Wikipédia aucun. Un petit 1/3 sont inoffensifs, par exemple pour se rappeler son mot de passe. Mais les logiciels espions ne s’en tiennent pas à des cookies et sont de plus en plus sophistiqués. Certains, par exemple, suivent ce que font les gens en temps réel, et évaluent instantanément le lieu, les revenus, les comportements d’achat et même les conditions médicales des personnes. Certains se réimplantent automatiquement quand les usagers cherchent à s’en débarrasser, notamment en profitant des fonctionnalités de Flash d’Adobe. La relation entre les profils et les noms des personnes n’est pas faite. Les profils sont, en toute rigueur, ceux des machines des utilisateurs.

Plus inédits sont les éléments, même partiels, donnés sur cette économie. Les profils des individus ainsi recueillis, constamment actualisés, sont achetés et vendus sur une sorte de bourse qui a pris son envol dans les derniers 18 mois. Le journal a ainsi identifié plus de 100 sociétés d’intermédiaires en concurrence sur les données comportementales et d’intérêts des individus. Parmi celles-ci la société BlueKai surveille, par exemple, les visiteurs de eBay.com ou de Expedia.com en temps réel et ces données sont revendues sur son site. Plus de 50 millions d’informations sur les habitudes de navigation des internautes sont vendues chaque jour à 1/10 de centime de $ pièce. On considère que la publicité ciblée a fait un chiffre d’affaires de 23 Milliards de $ l’année dernière.

Ces données peuvent être une rentrée supplémentaire pour des sites qui ne peuvent se financer complètement par la vente d’espace publicitaire. Il semble néanmoins que, naïfs, inconscients ou complices passifs, nombre de sites ne sont pas au courant des logiciels espions qu’ils transmettent et qui sont initiés par des entreprises-tiers d’un nouveau genre où règnent les statisticiens. Par ailleurs, si aux États-Unis l’utilisation des cookies est réglementée, les autres logiciels espions, bien plus intrusifs ne le sont pas, pas encore.

In fine, l’objectif est, bien sûr, de cibler au plus près le consommateur. Voici trois citations illustratives de l’objectif des responsables de ces sociétés : « Les annonceurs veulent accéder aux personnes, pas aux pages web » ; « Quand une publicité est correctement ciblée, elle cesse d’être une publicité pour devenir une importante information » ; « Nous dirigeons les gens vers différentes files de l’autoroute ». Mais, cette détermination a des limites. Il n’est pas sûr que nous voulions rester toujours dans les mêmes rails et nous sommes, comme tous les humains, heureusement versatiles.

2. L’importance du navigateur et des choix techniques

Un important débat a eu lieu à Microsoft au moment de la mise au point de Internet Explorer 8 entre les ingénieurs et les responsables de la stratégie. Les premiers avaient imaginé un navigateur qui protégeait par défaut la vie privée des internautes en les prévenant des logiciels intrusifs et leur donnant la possibilité de les bloquer. Mais suite à des pressions internes de nouveaux recrutés issus de la publicité sur le web et de la consultation des représentants de cette branche. La tendance a été renversée, rendant quasi-impossible cette protection, qui n’existe plus par défaut et qu’il faut réenclencher à chaque ouverture du navigateur.

L’épisode est intéressant à double titre. D’une part, il illustre combien la logique économique du web est radicalement différente de celle de l’économie classique des logiciels, culture initial de MSN, et repose exclusivement sur la publicité ciblée. D’autre part, il montre le rôle essentiel dans cette économie du navigateur dont les choix techniques ne sont pas gravés dans le marbre.

MSN, malgré tout, cherche encore à se démarquer de ses concurrents sur le web en appliquant une politique plus rigoureuse sur les données qu’il collecte, comme le montre cet article du journal de la firme :

Lee Pender, “Privacy: What Does Microsoft Know About You?”, Redmondmag.com, Janvier 7, 2010, ici.

L’épisode peut aussi faire réfléchir à la stratégie de Mozilla avec Firefox, drapé dans la vertu du logiciel libre, mais ne défendant pas mieux les données privées..

3. Cellulaire ou mobile

En Amérique du nord, on dit « téléphone cellulaire », en Europe « téléphone mobile », ou plus rapidement cellulaire et mobile. La différence sémantique est ironique, l’un insiste sur le repérage, le quadrillage voire l’enfermement, tandis que l’autre pointe la liberté, le déplacement. Sans doute, il s’agit de l’envers et du revers d’une même médaille, mais le pile et le face sont pour le moins contrastés. Une même technologie, un même service est désigné selon les continents par des qualificatifs opposés. Ici, je garderai « cellulaire », plus représentatif des propos du WSJ. Les compagnies de téléphone savent, en effet, où se trouvent leurs abonnés à trente mètres près.

L’article met en balance deux conséquences de ce repérage : d’un côté il indique la possibilité de repérer des victimes d’accidents ou de délits ou encore de sécuriser les enfants, qui justifie officiellement la réglementation US d’installation d’une puce GPS dans tous les téléphones cellulaires ; mais il insiste surtout sur les dangers du harcèlement et de la surveillance domestique, multipliant les exemples de femmes battues, retrouvées par leur mari grâce au traçage familial de leur téléphone portable proposé aux abonnés d’un cellulaire. En réalité, les enjeux me paraissent ailleurs : sur la surveillance policière ou le contrôle social d’un côté, la publicité contextualisée, de l’autre

Un chercheur d’une société de sécurité informatique, Don Bailey d’ISec Partners, a montré qu’il suffisait du numéro de cellulaire de la personne, d’un ordinateur, de quelques connaissances sur la technologie des cellulaires pour surveiller n’importe qui. Pour les paranos ou les incrédules, toutes les explications du chercheur sont ici . Il y explique comment il est possible de savoir, pour quelques cents et, tout de même, avec quelques compétences informatiques : qui vous êtes, quels sont les membres de votre famille, vos amis, vos collègues, où vous êtes, où ils sont, ce que vous êtes probablement en train de faire, pourquoi.. et ce que vous allez probablement faire ensuite.

4. Anonymat et personnalisation

Cet article donne une illustration concrète de ce qu’il est possible aujourd’hui de faire avec les données collectées. Il prend l’exemple de la société (x+1) qui a trouvé son modèle d’affaires en 2008 après de nombreux déboires et changements auparavant.

En utilisant les bases de données construites comme indiqué dans le premier article, la société est capable instantanément de donner le profil de consommation de n’importe quel internaute. Ils n’ont pas a priori son nom, mais croisent les références des données, avec la propriété des maisons, le revenu familial, le statut familial, les restaurants habituels, entre autres. Et en utilisant les probabilités, ils font des hypothèses sur les penchants de l’internaute. Le directeur de la société indique : « Jamais, nous ne savons rien sur une personne ».

Sans doute, il leur arrive de se tromper, mais leurs propositions sont suffisamment fiables pour qu’ils aient trouvé un marché auprès des vendeurs de cartes de crédit qui évaluent ainsi en temps réel la fiabilité de leurs nouveaux clients. Comme le dit le journaliste : « en résumé, les sites web ont gagné la possibilité de décider si vous serez un bon consommateur ou non, avant même que vous ne leur disiez quoi que ce soit sur vous-même ». Les conseils d’Amazon à partir de leur base de données maison sont largement dépassés. Ces techniques ouvrent la possibilité de construire un commerce personnalisé où produits, services ou même prix sont proposés selon le profil de chacun.

Mais la préservation de l’anonymat est toute relative et, par ailleurs même si ces sociétés disent ne pas faire de discrimination selon les genres, les profils ethniques, les handicaps qui tombent sous le coup de la loi, de tels profilages peuvent conduire facilement à des dérives éthiques. Ainsi, comme le titre de l’article l’indique, cette économie du web est limite.

5. Contextuel ou comportemental

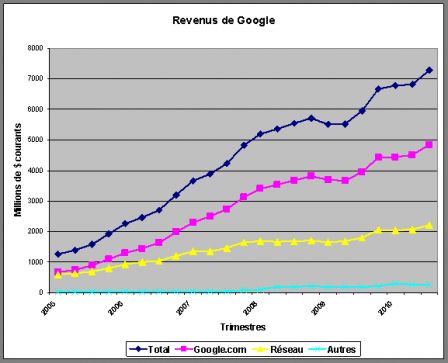

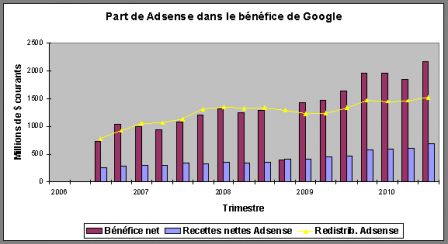

Le dernier article est celui qui m'a le plus intéressé. Il s'appuie sur un document interne de la société, remue-méninges qui montre les hésitations de Google pour l'exploitation des données qu'il récolte sur les internautes face à la montée de la concurrence. De part sa domination du marché de la publicité en ligne, la position de Google est déterminante à la fois vis-à-vis de ses concurrents et aussi vis-à-vis de l'évolution de la réglementation que chacun sent proche.

La firme détient par son moteur la plus grosse base de données sur les intentions des internautes, mais a résisté jusqu'à présent à surveiller ces derniers sans leur consentement pour préserver son image. Le savoir faire de Google est d'abord contextuel, une expertise de traitement des textes, aussi bien les requêtes des internautes que les documents publiés sur le web et non comportemental, une connaissance des réactions des personnes. Cette dernière expertise est celle de FaceBook ou des jeunes firmes présentés dans les autres articles de la série. D'un côté une expertise linguistique, de l'autre une expertise sociologique. C'est aussi dans ce contexte que l'on peut relire le slogan « don't be evil », on peut chez Google manipuler les mots, pas les personnes. Les débats internes à Google sur l'utilisation des cookies par exemple sont très vifs et ne sont pas sans rappeler les débats de MSN présentés dans un autre article de la série. Dans les deux cas le dilemme est le même : comment préserver la culture de l'entreprise tout en faisant face à la concurrence ?

Une animation très claire, qui accompagne l'article, montre combien aujourd'hui les données engrangées sont nombreuses, recueillies par diverses services de Google et sont encore cloisonnées pour leur exploitation publicitaire. Reste que l'article ne dit pas à quoi servent l'important stock de données collectées en dehors d'une utilisation pour la publicité, par exemple par la barre d'outil de Google.

Suite notamment à l'achat de Double-Click en 2007, à la montée de la concurrence dont Facebook, il semble que la position de la firme a évolué sur le cookies. D'ailleurs, l'enquête déjà citée (là) montrait que Google est très présent dans la surveillance. Une stratégie pour sortir du dilemme par le haut serait de devenir une bourse d'échanges de données ou une régie de publicité comportementale ciblée.

Actu 24 septembre 2010

Voir aussi :

The convergence of Google, government and privacy - O'Reilly Radar, ici.

Actu du 7 octobre 2010

Comme prévu, la régulation va très très vite dans ce domaine :

“Publicité ciblée : les Américains aussi se mettent à l'abri - Etreintes digitales,” ici.

Actu du 13 octobre 2010

Conformément à l'esprit français dans la continuité de la CNIL, l'argumentaire est plutôt mis ici sur l'éthique et non sur le commerce. Deux références :

Le livre de D. Kaplan, présentation ici

La signature de chartes sur le droit à l'oubli : pour la publicité ciblée (ici) et dans les sites collaboratifs (là). Signatures refusées par Facebook et Google.. entre autres.

Dans ce domaine, l'autodiscipline est peu efficiente, seule compte la norme comme le propose Helen Bissenbaum (là).

Actu du 18 oct 2010

Le WSJ continue à creuser le même sillon en en faisant une rubrique régulière What they know ici et notamment cet article :

Julia Angwin et Steve Stecklow, “'Scrapers\' Dig Deep for Data on Web,” wsj.com, Octobre 12, 2010, ici .

Actu du 26 octobre 2010

Voir ce nouvel article sur une levée de fonds de la société Cloudera.

Actu du 27 octobre 2010

A suivre :

“Confidentialité : Google poursuivi en justice aux Etats-Unis,” Le Monde, Octobre 27, 2010, ici.