Billet rédigé par Marine Vandermeiren, Cécile Etesse, Mathilde Dumaine et Julie Arros dans le cadre du cours Ecosystème du document de l'Enssib.

Il est des sujets d’actualité qui font couler de l’encre… même derrière un écran. Parmi eux, on peut citer le cas de la toute nouvelle bibliothèque numérique Numelyo, lancée par la Bibliothèque municipale de Lyon mi-décembre 2012. Celle-ci est le résultat d’un contrat passé entre la ville de Lyon et Google en juillet 2008, confiant au « géant tentaculaire » l’opération technique de numérisation du fonds ancien de la bibliothèque.

La ville de Lyon a-t-elle eu raison de contractualiser avec Google ? Telle est la question à l’origine de débats sur la blogosphère et des deux côtés, les arguments sont nombreux et souvent pertinents.

Un partenariat novateur et audacieux ...

Tout part du projet originel : y avait-t-il vraiment une alternative possible ? Un article de Télérama rappelle qu’un appel d’offre avait été lancé pour cette entreprise de numérisation auquel seul Google a répondu... Par ailleurs, l'ancien directeur de la BmL, Patrick Bazin, souligne la nécessité de ce partenariat sans lequel la bibliothèque n’aurait pas pris le virage numérique. Rappelons également, avec S.I.Lex que les clauses du contrat prévoiyaient que Google n’ait pas d'exclusivité d'indexation, ce qui constitue des conditions de négociations très favorables à la BM de Lyon, inédites jusqu’alors.

Et, en acceptant d’être résolument optimiste, ne pourrait-on pas dire que - en reprenant les termes de Robert Darnton dans un article de 2009 - ce contrat constitue un pas de plus vers la « démocratisation du savoir » ? Selon lui, la numérisation à grande échelle entreprise par Google participe pleinement de ce processus. A ce propos, il parle même de "pas tangible vers l’instauration d’une république des lettres et d’une citoyenneté universelle au sein de cette république". La valorisation des collections entreprise par la BmL relève de la même logique.

Mais R. Darnton nuance son propos, en insistant sur les regards croisés : se contenter d'un point de vue américain serait restrictif. Comme il l'exprime dans cet article, les Européens auraient tout intérêt à numériser leurs propres collections. Il précise à ce sujet que Google aurait une dévotion à l'intérêt public dont il se méfie.

Cela illustre bien l'ambiguïté de la phase de numérisation : loin de se réduire à une simple opération technique, celle-ci mêle toujours, de manière étroite, enthousiasme et incertitudes.

... encore loin de faire l'unanimité.

En effet, il ne faudrait pas oublier trop rapidement que « nouveau contrat » rime aussi avec problèmes techniques et enjeux juridiques. Au-delà de la menace d'un monopole du géant américain, différents points justifient que l’initiative de la BmL ne fasse pas l’unanimité.

Quid de l’opération de numérisation en elle-même ? En réalité, celle-ci pose deux questions toujours en suspend : celle de la pérennité et celle de la qualité. Il n’y a aucune garantie que les fichiers produits par Google puissent être lus dans quelques années, et l’entreprise numérise « uniformément », sans faire de différences entre les documents ni entre leurs éditions. En outre, les documents sont numérisés par des machines, donc pas à l’abri d’erreurs potentielles… R. Darnton émet lui aussi ses réserves quant à la pérennité des documents en parlant de la qualité de la numérisation, qui pourrait ne pas être complétement irréprochable, ainsi que des garanties de conservation.

D’un point de vue juridique, certains ont dénoncé les restrictions consenties par la BmL, en particulier la clause qui garantit l’exclusivité commerciale de 25 ans : jusqu’en 2033, la BmL ne pourra pas commercialiser les fichiers numérisés. Ce point n'est pas un obstacle majeur pour la BML qui n'a pas vocation à commercialiser ces données, mais cela pourrait devenir une possible menace en cas de changement de stratégie de la part de Google.

L’avenir dira si ces craintes sont fondées. Notons que la BnF - à l'époque de la signature du contrat - ne regardait pas ce partenariat d'un bon œil. Cependant, à l'heure actuelle, les tensions se sont apaisées et la BnF soutient le choix lyonnais, comme le note Rue89.

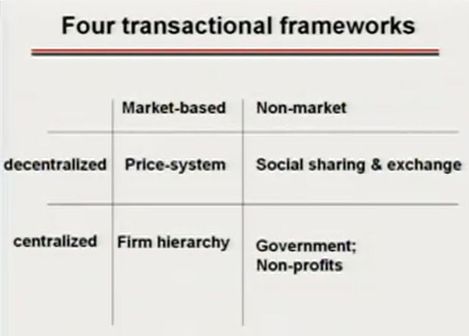

Mais un autre point mérite ici d’être noté : il semble bien que, contre toute attente, le débat qui avait pour origine la signature d’un contrat entre un service public et une entreprise privée se soit décalé. En lisant ici ou là, on a le sentiment que les critiques portent moins sur le bien fondé de cet accord que sur la manière dont il a été mis en œuvre par la BM de Lyon. Citons notamment l’utilisation d’une licence Creative Commons sur les documents pourtant tous issus… du domaine public, ce qui mène certains à parler de copyfraud. A cela s'ajoute des conditions d'utilisation... étonnantes : "En cas de publication sur quelque support que ce soit (livres, revues, journaux, affiches cartes postales imprimés ou électroniques, objets divers, internet…), l’utilisateur est tenu d’indiquer clairement la provenance du document telle qu’elle figure sur le site de Numelyo, sous la forme Bibliothèque municipale de Lyon, cote du document et de prévenir la Bibliothèque municipale de Lyon de la publication". La question pertinente ici serait peut-être davantage : est-ce toujours légitime de raisonner à partir du binarisme public/privé, service public/entreprise, à l’heure où nombre de ces logiques convergent et où les fractures semblent ne plus être là où on les attend ?