Par Jean-Michel Salaun le dimanche 16 janvier 2011, 12:25 - Édition

François Bon vient de baisser de façon conséquente le prix des livres sur Publie.net. Un livre téléchargé chez lui coûte désormais 3,49 Euros contre 5,99 auparavant (et même un peu moins pour les Québécois exonérés de TVA). Parmi ses explications, la plus trivialement économique qui est sans doute secondaire pour lui, mais nous intéresse ici au premier chef est celle-ci :

En baissant de façon conséquente ce prix standard de 5,99 à 3,49 (et 2,99 pour les formes brèves), j’ai l’intuition que ce ne sera pas pénaliser les auteurs – au demeurant, même sur un téléchargement à 3,49, une fois enlevés les 57 cts de TVA, reste 1,46 à l’auteur en vente directe, et 0,85 en vente avec intermédiaire - , mais au contraire déplafonner notre distribution, passer à une autre échelle.

Cela m'a rappelé deux autres billets assez spectaculaires. Le premier d'un auteur de roman policier américain prolifique, Joe Konrath, qui explique le 22 septembre 2010 comment il a vendu 103.864 ebooks. Extraits (trad JMS) :

Aujourd'hui, je vends une moyenne 7.000 e-books auto-édités sur le Kindle. Ces chiffres concernent les 19 titres auto-publiés, bien que les six premiers comptent pour plus de 75%, en gros 5000 par mois.

Cela signifie que ces six ont une moyenne de 833 ventes, ou rapportent 1.700$ par mois, chacun. Cela équivaut à 20.400$ par an et par livre pour mes meilleures ventes.

Il poursuit son exposé détaillé en expliquant comment il est arrivé à ce chiffre. En résumé, il a choisi de s'auto-éditer en réduisant drastiquement le prix de vente de ses livres à 2,99$. De ce fait, ses droits en pourcentage ont augmenté car ils sont partagés en moins d'acteurs, et en même temps l'augmentation des exemplaires vendus augmente mécaniquement les revenus de façon spectaculairement plus importante que le manque à gagner de la baisse du prix.

Cette aventure débute à peine. À la fin de 2010 j'aurai gagné plus de 100.000 $ sur mes livres auto-édités, et ce n'est rien comparé à ce que j'attends pour 2011. Et j'y réussis sans tournée, sans promotion non-stop, sans dépenser beaucoup d'argent, et sans compter sur personne d'autre.

Sans doute même s'il est exemplaire en particulier par la forte activité sur le web qui favorise certainement l'accès à ses œuvres, le cas de J. Konrath ne peut être reproduit pour l'ensemble des auteurs. C'est un auteur reconnu, expérimenté à succès de littérature populaire. Mais au delà du cas particulier, l'exemple pose la question de ce que l'on vend, sans doute un livre, mais un livre dans un écosystème fort différent et par là même dans un système de valeur très différent.

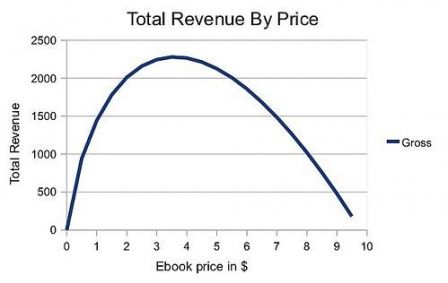

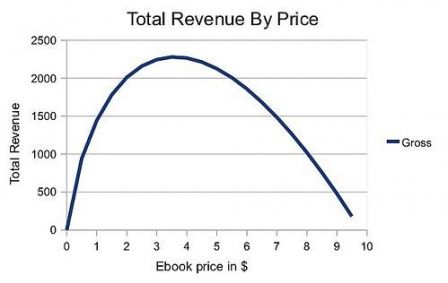

Avant d'y venir, il est utile de consulter un troisième billet, celui d'Evil Genius qui s'appuyant sur les chiffres de J. Konrath propose un petit modèle économétrique, dont le schéma ci-dessous résume bien la conclusion.

Bien sûr la construction du modèle est critiquable, ne s'appuyant que sur un exemple. Mais la démarche est utile et pourrait être menée de façon systématique avec les chiffres des grands acteurs. Le modèle est d'autant plus simple que les coûts variables de distribution dans le numérique sont très réduits. On peut même ajouter que la constitution de la maquette pour les livres récents ont été aussi très réduits par le numérique comme le montre l'étude de H Bienvault pour le MOTif.

En réalité ce modèle pose une question de fond qui est une petite révolution par rapport à la conception actuelle de la valeur éditoriale d'un livre. Il suppose de mesurer l'élasticité de la demande globale de livres par rapport à leur prix. Autrement dit, de supposer qu'un livre, ou plutôt un titre, est concurrent d'un autre en fonction de son prix, que les livres sont peu ou prou interchangeables.

On a tendance au contraire à penser qu'un livre, comme œuvre unique, est une sorte de monopole. On souhaite lire tel livre de tel auteur et on ne sera pas satisfait si on nous en propose un autre à la place. Et le droit d'auteur confère bien à ce dernier un monopole sur l'exploitation de son livre, qu'il peut ou non déléguer. Cette conception trouve sa traduction économique dans le modèle éditorial qui permet d'équilibrer le système global par une sorte de péréquation entre les revenus des titres à succès et ceux plus confidentiels. L'élasticité de la demande par rapport au prix serait faible dans le livre.

Mais l'arrivée du web et surtout la montée des tablettes modifient considérablement la donne et l'attitude du lecteur. Sur un Kindle ou un iPad, on n'achète pas un livre, on se constitue une bibliothèque. On peut lire un livre de la première à la dernière page, mais on en lit souvent plusieurs en même temps et on pourra y revenir à tout moment, à la bonne page ; ou encore on se contentera de feuilleter un grand nombre de livres, zappant de l'un à l'autre, faisant des recherches. Et tout cela en tout lieu, à tout moment, du fait de la portabilité de sa bibliothèque réduite à une tablette. Nous retrouvons un propos souvent tenu ici : le modèle du web est hybride entre celui de la bibliothèque et celui de la télévision.

Dès lors, sans doute le lecteur sera attiré par tel ou tel titre particulier, mais la valeur principale est constituée par l'ampleur et l'adaptation de la collection qu'il pourra constituer et par la vitesse et la commodité de l'accès aux pages. Cette donnée nouvelle modifie vraisemblablement considérablement la sensibilité au prix et donc l'élasticité de la demande, d'autant que le web tend à tirer les prix du contenu vers le bas par l'abondance des ressources accessibles gratuitement et que constituer une collection est un investissement de départ non négligeable pour un e-lecteur.

Conclusion si cette analyse est juste, F. Bon a eu bien raison de baisser drastiquement ses prix.

Codicille : cela pose aussi des questions sur la place et l'économie des ebooks dans les bibliothèques comme institution. Il faudrait que j'y revienne.

Voir aussi la table ronde de la SACD du 17 janvier ici.

Actu du 21 janv 2011

Sur le contrat d'édition, voir la synthèse de M de Battisti.