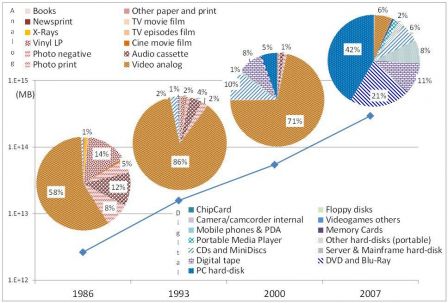

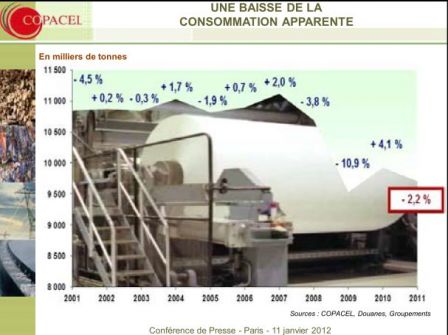

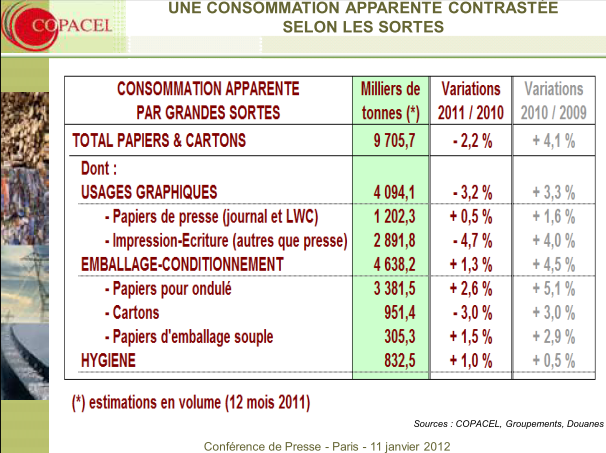

Début 2012, on est loin des prédictions apocalyptiques de Pierre-Marie de Biasi sur l'explosion de la demande de papier et plus encore de leur contraire sur le bureau sans papier (wkp). La consommation de papier graphique a fortement augmenté jusqu'aux années 2000 et aurait plutôt tendance à stagner et reculer ces toutes dernières années, mais il est difficile de dire s'il s'agit du résultat immédiat de la crise (qui réduit les échanges, et donc les documents) ou de l'effet à retardement du numérique (dont les effets sur les pratiques sont plus lents que l'implantation des systèmes), sans doute une combinaison des deux.

Un observateur attentif, Jacques de Rotalier, note que sur les prévisions mondiales 2010-2015 globalement, les zones développées devraient voir leur consommation diminuer légèrement (-1,5%) tandis que celle des zones émergentes devrait augmenter de 4 à 5%. La fusion de ces chiffres donnerait un supplément de consommation mondiale de 2,5 à 3% l’an : on est loin du développement exponentiel du numérique !. On ne dispose pas encore des chiffres pour 2011, mais en France la production de papier à usage graphique a diminué de 3,9% sur les dix premiers mois de l'année, d'après le recueil mensuel de la COPACEL. J'actualiserai les chiffres quand ils seront connus. En résumé la consommation de papier graphique reste en chiffres absolus très forte, même si elle a tendance à se tasser ces dernières années, notamment à cause de la réduction du papier journal.

Actualisation, conférence de presse de la COPACEL (signalée par J de Rotalier, merci à lui)

La problématique courante qui tend à faire du numérique un substitut au papier est ambigüe. En réalité, la question est moins celle du numérique que de l'affichage ou de la sortie, de l'artefact qui autorise la lecture, du support sur lequel s'affichent les signes, qui bascule selon les usages et les opportunités entre l'écran ou le papier imprimé. Pour bien analyser les positions respectives de l'un et de l'autre, il faut admettre qu'il ne s'agit plus aujourd'hui que de deux modalités complémentaires, éventuellement concurrentes, d'affichage de documents tous numériques. On peut, pour commencer, visionner cette petite vidéo qui m'a donné l'idée de ce billet :

Hello Little Printer, available 2012 from BERG on Vimeo.

Repéré par H. Bienvault

Il y a plus de formats différents de papier imprimé correspondant à des usages différents que de types d'écran. Délà le codex du livre n'est pas celui du journal, l'un et l'autre, se déclinant en diverses familles selon le genre ou la régularité des publications. Mais le codex n'est pas, non plus, la seule forme possible pour des documents imprimés. La feuille simple connait aussi divers formats depuis l'affiche jusqu'au Post-it en passant par la liste de course et surtout l'explosion de la feuille A4, sortie d'imprimante, agrafée ou non. La vidéo nous montre que les imprimantes ne sont pas, non plus, condamnées à ce seul format et que les messages instantanés peuvent aussi se distribuer sur papier, y compris à distance.

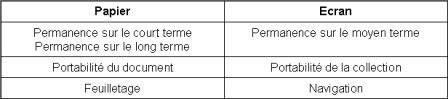

Ce qui est sûr, c'est qu'aujourd'hui les documents, quels que soient leur format et leur modalité d'affichages sont tous à l'origine numériques, à de rares exceptions près. Sachant que l'écran et le papier restent privilégiés la question devient : quel est le support le plus opportun pour un usage donné ? Entre l'écran et le papier, chacun à ses avantages. Sans prétendre faire le tour de la question, on peut remarquer déjà des avantages contrastés entre l'un et l'autre selon trois critères de base : la permanence, la portabilité et la lecture. Je les ai résumés sur un petit tableau.

Le papier imprimé l'emporte sur l'écran sur la permanence à court terme, tout simplement parce qu'il ne risque pas de s'effacer contrairement à l'écran, c'est cet avantage qui est mis en avant dans la vidéo. Mais à moyen terme, l'écran l'emporte car le papier est encombrant et devient vite difficile à retrouver, tandis que les serveurs gardent en permanence l'accessibilité immédiate des documents sur écran. Nul ne connait à long terme la possibilité de réafficher un document sur écran, tandis que le papier a fait ses preuves pour la conservation, pour peu que l'on prenne les bonnes mesures.

Un document individuel est en général plus facile à transporter sur papier, pourvu qu'il ne soit pas trop volumineux. Inversement, dès que le nombre de documents s'accroit, l'écran qui facilite l'ubiquité reprend l'avantage.

Enfin les modalités de lecture ont des avantages aussi contrastés dans les deux cas. Le feuilletage est plus simple sur papier, car il autorise la vue simultanée des feuilles sans trop d'encombrement de l'espace. Par contre s'il s'agit de naviguer d'un document à l'autre de façon plus ou moins aléatoire et d'y exécuter des traitements, l'écran est plus performant.

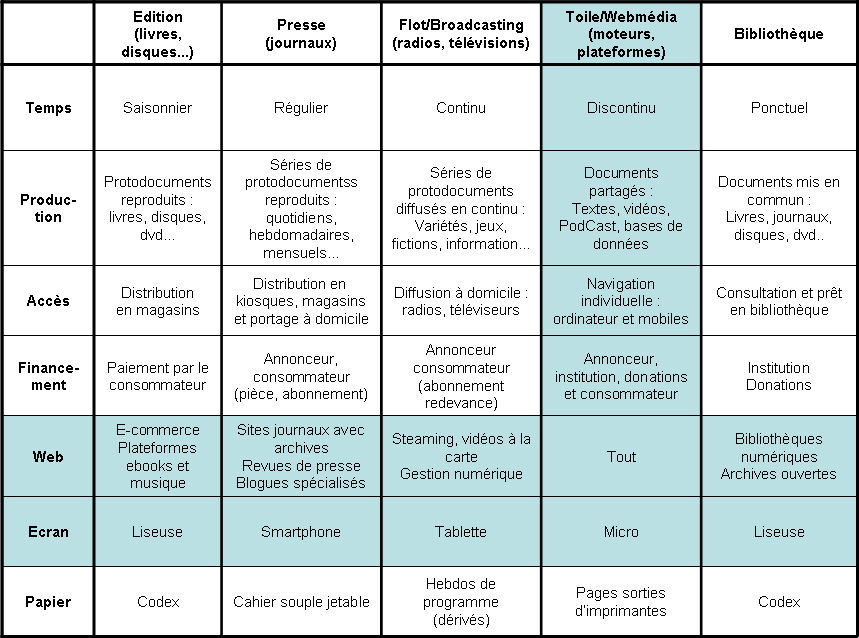

Sans doute on pourrait discuter ces affirmations et proposer d'autres critères. Je voulais juste ici suggérer des pistes de raisonnement. Celles-ci me permettent de compléter par une ligne mon tableau des différents modèles de publication déjà présenté dans un précédent billet. Je n'ai pas le temps de commenter. Ce sera pour une autre fois. Mais j'attire votre attention sur le critère de l'espace et du temps pour expliquer aussi bien les différents formats papiers (y compris l'impossibilité de rendre compte directement du flot) que les formats d'écran.