Ce billet vient à la suite du précédent sur la révision de la séquence 2 du cours et plus précisément sur la nécessaire actualisation de la partie sur les marchés financiers du fait de la crise. S2 D18 à 23 08. Ces diapositives et leur commentaire sont à revoir. On trouvera ci-dessous quelques éléments pour la révision.

La notion d'oligopole à frange, indiquée dans la diapositive 23, est bien connue des économistes qui travaillent sur l'innovation. Elle signifie que quelques firmes, qui ont pris une position dominante sur un marché donné, laissent se développer dans leur frange un grand nombre de petites firmes innovantes. Ainsi le risque de l'innovation, difficile à assumer pour des entreprises ayant une position assise, est pris par d'autres. Le succès éventuel d'un plus petit sera racheté ou récupéré par les plus gros, les échecs sont nombreux mais ne mettent pas en péril les principaux acteurs de la branche. Les industries du contenu, industries de prototypes donc par nature innovantes, sont très souvent structurées ainsi. Autour des gros éditeurs, des majors de la musique ou de l'audovisuel, en passant par les grandes stations de télévision, on retrouve une multitudes de petits entrepreneurs qui n'ont d'autre choix que de prendre des risques et assurent ainsi une part de la vitalité et du renouvellement de la création. Les mécanismes financiers varient suivant les branches et surtout suivant les besoins en capitaux. Le budget de production d'un film n'est pas le même, en volume et structure, que celui d'un livre et les formes de dominations des gros sur les petits varient aussi, depuis la filialisation jusqu'à diverses formules d'articulation. Néanmoins on retrouve bien dans les industries du contenu le même type de dialectique entre une concentration de l'activité sur quelques firmes, souvent jusqu'à l'oligopole, et un foisonnement, un éclatement sur de très nombreux entrepreneurs, fragiles mais pleins d'idées.

Les industries du Web paraissent structurées suivant le même modèle, mais je voudrais suggérer dans ce billet que l'homologie n'est qu'apparente. Les relations entre l'oligopole et la frange y ont des caractéristiques originales. Celles-ci s'accusent en ces temps de crise et tout cela n'est pas sans conséquence en retour sur les industries de contenu. Je prendrai exemple principalement sur l'étude de la position hégémonique prise par Google.

Le développement de l'innovation sur le Web s'est beaucoup appuyé sur les fonds de capital-risque (venture capital), auxquels les industries de contenu, industries anciennes, ne font pas appel. Le principe de ce type d'investissement est bien expliqué dans un bulletin récent de l'ADIT (BE États-Unis 162, voir aussi TechCrunch). Ces fonds prennent un pari sur une entreprise, start-up ou jeune pousse, accompagnant sa montée en puissance jusqu'à sa mise en bourse. Il y eut un premier raté au tournant du millénaire, avec la bulle internet, comme c'est expliqué dans le cours (D20). C'est d'ailleurs à la même époque que la firme Google a pris son essor, ce qui montre bien le caractère limité et conjoncturel de la bulle d'alors.

Fondée en 1998, la firme obtient en juin 1999 25M $ de sociétés de capital-risque et fait son entrée en bourse en 2004. L'exemple est éloquent. Depuis en effet Google a pris la position hégémonique que l'on connait. Il suffit de lire la liste de ses acquisitions (wkp) pour constater que l'on est bien dans un processus d'oligopole (avec MSN, News-Corp, eBay, Amazon...) à frange. Notons que toutes les réussites concernent des sociétés qui ont développé une innovation qui a séduit un grand nombre d'internautes et un modèle d'affaires permettant de substantielles rentrées financières.

Une logique perverse

La situation a évolué récemment. Compte tenu de la crise financière actuelle dont l'origine n'est pas cette fois dans la branche numérique, le système de capital-risque est aujourd'hui grippé. Pour le numérique, la difficulté est néanmoins double : d'une part la crise financière réduit l'argent disponible (passé aux US de 30 à 10 Mds de $ en 2009) et rend aléatoire l'entrée en bourse à terme qui est pourtant l'objectif recherché ; d'autre part la valorisation des activités sur le Web a montré ses limites et donc y rend moins attrayant les investissements.

Depuis la bulle internet, il n'est pas sûr même que le débouché principal recherché par les jeunes pousses soit la bourse. Bon nombre de celles-ci souhaitent plutôt se faire racheter par ceux qui ont pris une position forte, difficile à concurrencer car nous sommes dans un processus où le gagnant prend tout (selon l'expression de Franck et Cook, amz).

Dès lors, l'objectif est moins de se rentabiliser sur un marché que de démontrer que l'application que l'on développe pourrait détruire le marché des firmes installées en détournant les internautes. C'est une version quelque peu pervertie de la fameuse création destructrice de Schumpeter (LSE). On détruit de la valeur économique, sans pour autant en construire vraiment par ailleurs. Nous sommes alors dans une logique bien différente de celle des industries du contenu où l'innovation des petites firmes fait découvrir de nouveaux auteurs, oeuvres ou thèmes qui se valorisent sur des marchés. Ici on cherche à capter l'attention des internautes, sans pour autant la revendre ou vendre l'objet de cette captation, mais juste pour menacer les plus installés donc les plus riches et récupérer un peu de leur richesse. En caricaturant, on pourrait dire qu'il s'agit d'un raisonnement mafieux. Cette économie spéculative ne peut évidemment fonctionner que si ceux que l'on menace ont les moyens financiers de se défendre. En réalité, voilà bien comment fonctionne l'économie du Web 2.0.

L'ironie du système est qu'il trouve un allié objectif chez les militants de la démocratie internet, prompts à se mobiliser pour défendre la gratuité sous toutes ses formes. Il trouve aussi un appui dans une sorte d'économie souterraine faite de nombreux petits acteurs, et même les individus, qui baissent leurs coûts de transaction et élargissent leur zône d'achalandage sans contrepartie gràce aux réseaux et aux plateformes mis à disposition.

Pour ceux qui ne seraient pas convaincus, je prendrai seulement deux exemples emblématiques : YouTube et FaceBook. Le premier a été racheté par Google 1,65 Mds de $ en 2006. Il est devenu le deuxième moteur de recherche aux US. Et pourtant, il n'arrive pas à se rentabiliser et pourrait perdre jusqu'à 470 M de $ selon de Crédit Suisse cette année (merci à D. Durand pour sa veille attentive sur ces questions). FaceBook, on le sait, est un énorme succès de fréquentation, il vient d'annoncer avoir atteint la barre de 200 millions d'utilisateurs. La firme a déjà levé pour 15 Mds de $ de capital risque et en chercherait de nouveau pour la même somme, non sans de grosses difficultés vu son absence totale de rentabilité et l'état de la bourse (TC).

Le rôle de Google

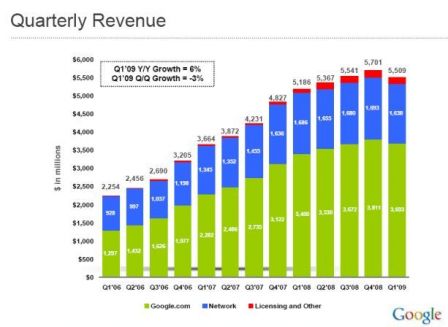

Revenons donc à Google. Pour bien comprendre son fonctionnement et la position particulière de la firme, il faut observer la structure de son chiffre d'affaires. Voici son évolution selon les derniers résultats du premier trimestre 2008 :

Diaporama complet ici

Diaporama complet ici

La première évidence bien connue des lecteurs de ce blogue est que, malgré ses tentatives de diversification, le chiffre d'affaires de Google est encore et toujours quasi exclusivement du à la publicité (98%). J'ai déjà eu l'occasion de faire remarquer (ici) combien l'évolution de sa structure signalait un recentrage progressif sur le métier originel de la firme, la recherche d'information financée principalement par adwords en vert plutôt que la régie publicitaire (adsense) en bleu. Je ne reviens pas non plus les conséquences pour les industries de contenu (par ex ici).

La baisse du chiffre d'affaires de Google début 2009 et qui semble devoir se confirmer au trimestre suivant même si elle reste relative va conduire les dirigeants à la prudence. Voir sur cette question le compte-rendu de Cnet-News (ici). La première conséquence sera d'accentuer encore la tendance précédemment citée.

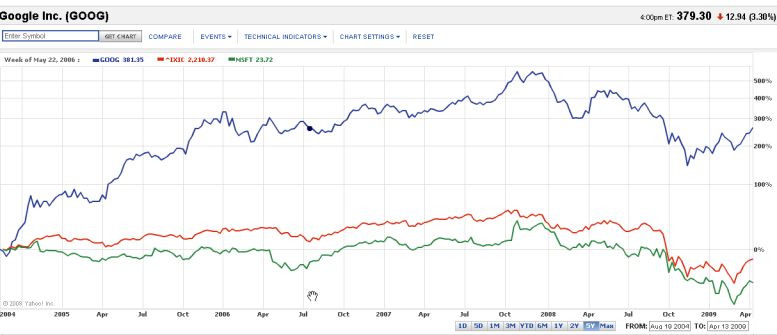

Néanmoins, la firme dispose d'un énorme trésor de guerre qui l'autorise des investissements importants. Par ailleurs, compte-tenu de son succès financier, la position du titre de Google en bourse reste confortable, très supérieure à la moyenne du Nasdaq (actualiser D22).

Dans ces conditions, il est probable que Google va accentuer encore sa domination sur le secteur en favorisant le développement d'une frange qui trouvera de moins en moins d'interlocuteurs vers qui se tourner et qui sera de plus en plus vassalisée.

La firme vient d'ailleurs de lancer son propre fond de capital risque et compterait investir 100M $ pour 2009 (BE États-Unis 161). Autre exemple, elle s'intéresse de près à Twitter, qui ne dispose lui non plus pas du moindre début d'un Business model.

Par ailleurs, Google serait "très, très heureux" d'aider Twitter ou d'autres sites Internet de "communication immédiate" à gagner de l'argent, a indiqué Eric Schmidt, en évoquant des pistes pour rentabiliser le site de micro-blogs. "Sans parler spécifiquement de Twitter", ces sites pourraient devenir "un moyen de canaliser des informations marketing", et à partir de ce moment-là, "d'accrocher des produits publicitaires", a-t-il relevé. Le Monde du 17-04-09, ici.

En complément voir l'intéressante analyse d'O. Ezratti qui montre la domination des capitaux publics dans le capital-risque en France.

Actu du 30-04 2009

Deux références complémentaires signalées par InternetActu. La première confirme en le précisant les difficultés économiques des sites de Crod Sourcing dues notamment au coût de la bande passante et à la difficulté de monétarisation :

Farhad Manjoo, La bande passante ne se trouve pas sous les sabots d'un cheval, Slate 22 avril 2009, ici

L'autre développe, à partir de l'exemple de l'iPhone, une idée complémentaire et non abordée ici, celle de l'écosystème. Une façon webilitiquement correcte de parler d'oligopole à frange, mais la domination s'y exerce différemment que dans l'analyse ci-dessus et il serait bon que j'y revienne à l'occasion :

Alexis Mons, Leçon d'économie systémique, 24 avril 2009, Groupe Reflect, là.

Actu du 1-05-2009

Voir aussi dans la même logique, mais chez Amazon, le rachat de Lexcycle. Chez V Clayssen (ici et là).